Von Industrial Big Data zu Smart Data – Wie aus Produktionsdaten Erkenntnisse werden

Die Digitale Transformation und die mit ihr einhergehenden Implikationen haben in der jüngsten Vergangenheit tiefgreifende Veränderungen in vielen Lebensbereichen hervorgerufen. Bedingt durch die zunehmende Nutzung von Smartphones und den allumfassenden Zugriff auf jedwede Form von Information geht mit der Digitalisierung nicht nur ein weitreichender gesellschaftlicher Wandel einher, sondern es findet ebenso eine Neugestaltung vieler technischer Bereiche statt, wie zum Beispiel in der Mobilität oder im Kontext der industriellen Produktion. Diese Veränderungen sind dabei grundlegend auf eine Vergrößerung der zur Verfügung stehenden Datenmengen zurückzuführen, zusammengefasst unter dem Begriff "Big Data". Der Begriff bezeichnet im Allgemeinen die kontinuierliche Nutzung großer Datenströme zur Gewinnung von Erkenntnissen, welche zum Beispiel in einer besseren Verfügbarkeit von Diensten münden können, oder aber den Nutzer besser "kennenzulernen", um ihm zum Beispiel relevantere Suchergebnisse zu unterbreiten.

"Industrial Big Data" sind Datenmengen, welche im Produktionskontext entstanden sind bzw. kontinuierlich entstehen und in diesem Bereich ihre Anwendung finden. Dabei sind nicht nur Informationen relevant, welche während des Produktionsprozesses generiert werden, wie beispielsweise durch Maschinen und Anlagen, sondern auch diejenigen Informationen, die beim späteren Einsatz im Feld, also z. B. auf der Straße oder bei der Nutzung direkt beim Kunden, entstehen und nutzbar gemacht werden können. Durch das Zusammenführen all dieser meist heterogenen Daten lassen sich in der Regel Muster in den aggregierten Informationen identifizieren und in der Folge Erkenntnisse ableiten, die im Produktionsprozess von großem Nutzen sind, beispielsweise hinsichtlich einer Verbesserung der Produktqualität oder aber hinsichtlich einer Optimierung der Fertigungssystematik.

Dieser Artikel gibt einen Überblick der aktuellen Chancen und Herausforderungen, die sich insbesondere im industriellen Bereich mit großen Datenmengen in Verbindung bringen lassen. Dies erfolgt in mehreren Schritten:

- Zunächst werden einige Grundbegriffe erläutert, wie zum Beispiel der häufig verwendete Industrie-4.0-Term oder aber das Internet der Dinge (IoT), welches im Rahmen der Produktion im Idealfall in einer Art "Internet of Production" mündet.

- Danach liegt der Fokus auf der Entstehung von "Industrial Big Data". Voraussetzung hierfür ist zunächst die erfolgreiche Vernetzung von Informationsquellen, um eine kontinuierliche Sammlung und Integration von Daten sicherzustellen.

- Im Anschluss erfolgt eine Betrachtung, wie große industriellen Datenmengen generiert werden bzw. wie sich diese in einer kontinuierlichen, durchgängigen Art und Weise integrieren lassen.

- Nach einer Gegenüberstellung von "Industrial Big Data" mit traditionellen "Big Data" hinsichtlich einer zielführenden Nutzung folgt schließlich ein Ausblick, der die Potentiale der gesammelten Daten im Produktionskontext beleuchtet.

Industrie 4.0 und das Internet of Production

Die Chancen, die sich durch Industrial Big Data sowie durch datengetriebene Technologien allgemein ergeben, werden oftmals unter dem Begriff "Industrie 4.0" zusammengefasst. Dieser bezeichnet die Digitalisierung bzw. die digitale Transformation in der Industrie durch neuartige Technologien wie die Künstliche Intelligenz oder das Maschinelle Lernen. Gerade in jüngster Zeit haben die Diskussionen rund um die Chancen von Künstlicher Intelligenz wieder stark zugenommen. Bahnbrechende Erfolge wurden in vorher nicht geahnten Disziplinen erzielt. In Schach, Go, oder aber auch komplexen Computerspielen sind die Algorithmen mittlerweile dem Menschen überlegen.

Die genannten Entwicklungen machen dabei auch vor der industriellen Produktion nicht halt. Die Vision der Industrie besteht in diesem Zusammenhang in der Schaffung einer intelligenten, vernetzten Fabrik, basierend auf einer Art "Internet of Production", also einem offenen Standard für die weitreichende Vernetzung. Auf Basis dieser angestrebten Vernetzung sollen so ähnlich wie im traditionellen Internet, Dienste realisiert werden, die eine Verbesserung sowie eine Flexibilisierung des Produktionsprozesses und der gesamten Wertschöpfungskette mittels Künstlicher Intelligenz oder ähnlicher intelligenter Algorithmen und Verfahren ermöglichen. Auf Basis dieser Dienstarchitektur soll es in der Folge einfacher werden, beispielsweise spezielle Kundenwünsche besser zu berücksichtigen, oder aber auf Lieferengpässe oder mögliche Probleme in der Fertigung schneller zu reagieren. Möglichen Szenarien innerhalb dieser "Fabrik der Zukunft" sind hierbei nahezu keine Grenzen gesetzt.

Die reine Digitalisierung von Systemen und Anlagen ist eher der dritten industriellen Revolution zuzuordnen.

Die notwendigen Voraussetzungen für die Anwendung der oben genannten Technologien werden bei der Diskussion über die Potentiale von Industrie 4.0 oftmals vernachlässigt, sind jedoch von entscheidender Bedeutung für die Realisierung dieser intelligenten Fabriken. Eine der notwendigen Grundlagen liegt dabei in der Vernetzung von Datenquellen in der Produktion, also zum Beispiel von Maschinen, Anlagen und Sensoren, jedoch ebenso von Planungs- und Managementsystemen. Die Vernetzung soll darüber hinaus in einer globalen Weise erfolgen. Ein weit verbreiteter Irrtum in diesem Zusammenhang ist häufig darin zu finden, dass der Industrie-4.0-Begriff mit einer Vernetzung von automatisierungstechnischen Anlagen gleichgesetzt wird. Dies ist jedoch nur die halbe Wahrheit. Ganz im Gegenteil ist die reine Digitalisierung von Systemen und Anlagen eher der dritten industriellen Revolution zuzuordnen. Der grundlegende Unterschied bei der Industrie 4.0 besteht vor allem in einer globalen Verfügbarmachung von Informationen über Anlagengrenzen hinweg, in Abgrenzung zu einer "lokalen" Digitalisierung einzelner Anlagen oder Steuerungen.

Darüber hinaus werden durch diese allumfassende Digitalisierung zunehmend auch von den Produkten selbst oder von den Menschen in der Fabrik generierte Daten immer interessanter für eine gemeinschaftliche Betrachtung mit den übrigen Daten aus der Produktion. Aufgrund der Verschiedenartigkeit derartiger Datenquellen ist es in der Praxis jedoch oftmals schwierig, eine generische, standardisierte Vorgehensweise zu etablieren, die es ermöglicht, diese verschiedenartigen Daten aus unterschiedlichen Quellen erfolgreich in eine gemeinsame Datenbank oder einen ähnlich gearteten ganzheitlichen Speicher zu integrieren, um eine datengetriebene Analyse zu ermöglichen.

Im Rahmen des derzeitigen Stands der Technik konzentrieren sich die Aktivitäten bei der Vernetzung in der Produktion größtenteils auf Maschinen, Sensoren, sowie automatisierungstechnische Anlagen, wie zum Beispiel speicherprogrammierbare Steuerungen (SPS). Trotz der zumeist eingespielten Funktionsweise dieser Komponenten innerhalb des Betriebs automatisierungstechnischer Systeme und ihrer stabilen Funktionsweise sieht man sich bei der umfassenden Vernetzung dieser Geräte jedoch oftmals größeren Herausforderungen gegenüber, die auf die bereits genannte ausgeprägte informationstechnologische Heterogenität der Systeme und Anlagen zurückzuführen sind. Im Fachjargon spricht man dabei vom "Brown Field" sowie von "Legacy-Systemen". Der Brown-Field-Begriff steht dabei für gewachsene Systemlandschaften, welche in einer langjährig bestehenden Produktionsstätte entstanden sind und sich aus Technologien unterschiedlichen Alters und verschiedenster Generation zusammensetzen. Ähnlich hierzu beschreiben "Legacy-Systeme" derartige Hardware- und Softwarekomponenten, die nicht oder nur in geringem Umfang Updates erfahren können. Grund für den Einsatz dieser meist veralteten Systeme sind zumeist die hohen Investitionskosten, die mit einem ständigen Update der verschiedenen Komponenten in den technischen Systemen verbunden wären. So bleibt in der Praxis oftmals nur die Möglichkeit, speziell auf die veraltete Hard- oder Software angepasste Skripte oder ähnliche Lösungen für die Integration von Daten vorzunehmen, was sich in der Regel als nicht skalierbar erweist.

Standardisierung in der industriellen Produktion

Neuartige Standardisierungsvorhaben im Rahmen der industriellen Produktion setzen an diesem Punkt an und versuchen, gemeinsame Standards bei der Datenübertragung hinsichtlich eines sogenannten "Industrial Ethernet" zu etablieren. Dieses hat das Ziel, eine gemeinsame netzwerktechnologische Grundlage für die Vernetzung jedweder Systeme in der Fabrik zu schaffen, ähnlich zum Ethernet-Standard traditioneller Computer-Netzwerke. Das Ziel besteht hierbei darin, auch ältere, jedoch weiterhin etablierte Feldbus-Protokolle zu unterstützen, wie z. B. PROFIBUS, Modbus, etc. durch die Nutzung geeigneter Adapter oder Aufbau-Protokolle wie zum Beispiel PROFINET IO, Modbus TCP, Ethernet Powerlink, um nur einige zu nennen.

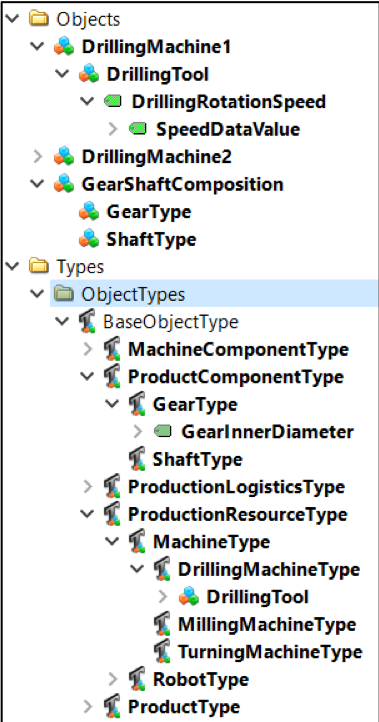

Basierend auf einer einheitlichen Netzwerk-Technologie lassen sich dann sogenannte semantische Protokolle und Meta-Standards definieren, die eine Modellierung der Komponenten in einer Fabrik mittels eines einheitlichen Informationsmodells erlauben. Eines dieser Vorhaben, das sich innerhalb der vergangene Jahre im Zuge dieser Bestrebungen zu einer Art De-Facto-Standard etabliert hat, ist das Meta-Modellierungs-Protokoll "OPC Unified Architecture", oder auch kurz OPC UA. Der Standard ist Teil der sogenannten "Referenzarchitektur Industrie 4.0" (RAMI 4.0) und gilt als Enabler-Technologie für die weitreichende Vernetzung in der Produktion. Der größte Vorteil dieses Protokolls liegt hierbei in der strikten Trennung der syntaktischen Auslegung von Kommunikationsvorgängen (z. B. Nutzung von TCP/IP) und der strukturierten Modellierung der eingehenden Informationen. Letztere wird dazu verwendet, eine Strukturierung von beispielsweise Maschinen, Anlagen oder Sensoren in Form eines Informationsmodells vorzunehmen. Dies geschieht mittels einer Methodik, die der objektorientierten Programmierung ähnelt. So lassen sich beispielsweise Klassen, Attribute und Objekte modellieren und in Relation setzen. In Abb. 1 ist eine beispielhafte Darstellung eines OPC-UA-Informationsmodells mit Objekthierarchien in Form von Klassen (Types) sowie Instanzen (Objects) abgebildet.

Der oben vorgestellte Standard ist ein Versuch, gerade etablierte Produktionssysteme mit bestehenden Anlagen und gewachsenen Systemlandschaften informationstechnologisch zu integrieren. Viele Systemhersteller, Zulieferer und weitere Player industrieller Wertschöpfungsketten haben die Notwendigkeit dieser Entwicklungen bereits erkannt, und legen ihre Lösungen entsprechend interoperabel aus, andere Hersteller sind hier noch weitaus restriktiver eingestellt, beispielsweise zur Sicherung der eigenen Marktstellung.

IoT-Standards für die Produktion

Neuartigere Entwicklungen zur Schaffung informationstechnologischer Integrität in der Produktion basieren auf sogenannten Internet of Things (IoT)-Standards. Der Trend des Internet der Dinge, der seine Ursprünge im Smart-City- sowie Smart-Home-/Home-Automation-Kontext hat, nimmt ebenfalls immer stärker Einzug in die Produktion. So setzen einige Hersteller bereits auf die native Integration leichtgewichtiger Protokolle in ihre Maschinen und Steuerungen. Derartige IoT-Protokolle basieren zumeist auf dem sogenannten Publish-Subscribe-Prinzip (kurz Pub/Sub), welches eine unkomplizierte One-To-Many-Kommunikation ermöglicht, also einen Informationsaustausch von einem oder wenigen Publishern (Veröffentlichern) zu einer beliebigen Zahl an Subscribern (Abonnenten). Das Prinzip ähnelt dabei der Kommunikation mittels Kurznachrichtendiensten und basiert auf sogenannten "Topics", die sich wie Hashtags (#) verstehen lassen und die Veröffentlichung einer Nachricht unter einem gewissen "Topic", d. h. unter Bezugnahme auf ein bestimmtes "Thema", ermöglichen. Bei dieser Art der datenzentrierten Kommunikation ist es möglich, eine Flexibilisierung von informationstechnischen Netzwerken zu erreichen, in denen die Konsumenten von Daten nahezu beliebige Themen und damit Quellen abonnieren können, die Publisher dieser Daten jedoch keine Direktverbindung zu diesen Datenkonsumenten benötigen. Der Grund hierfür liegt in einer automatisierten Weiterleitung der Nachrichten durch einen sogenannten "Broker", eine Art Cloud-Lösung zur Weiterleitung und Zustellung von Nachrichten. Die folgende Abb. 2 verdeutlicht, wie ein derartiges Prinzip in der industriellen Produktion realisiert werden könnte.

Die Informationsquelle ist hier schemenhaft in Form einer Produktionsmaschine dargestellt, welche eine Verbindung zum Broker, hier "Publish-Subscribe Cloud", unterhält. Innerhalb dieses Brokers sind mehrere Topics, also mögliche Themen, registriert, zum Beispiel eines mit der Bezeichnung "Alarms". Sobald eine der Informationsquellen nun auf diesem Thema Nachrichten veröffentlicht, werden diese Nachrichten automatisch an die Abonnenten des entsprechenden Themas weitergeleitet. Abonnent können dabei beliebige Geräte, Datenbanken oder aber auch Smartphones und Smartwatches sein, die ebenso einen Zugriff auf das entsprechende Netzwerk haben. Anhand dieses Beispiels wird die Flexibilität des Ansatzes deutlich: Der Publisher von Informationen muss nicht wie in traditionellen Netzwerken mit Point-to-Point-Verbindung sämtliche seiner Datenkonsumenten "kennen", sondern kann Nachrichten empfängeragnostisch veröffentlichen. Jeder Subscriber kann also selbständig darüber entscheiden, welche Nachrichten er erhalten möchte oder nicht.

Das vorgestellte Szenario eröffnet weitreichende Anwendungsgebiete in der Produktion, nicht nur für die Datenintegration, sondern insbesondere in Bereichen wie der intelligenten Wartung von Maschinen und Anlagen (Predictive Maintenance), bei der wichtige Informationen schnell und flexibel zum richtigen Empfänger gelangen müssen. Eines der Protokolle, welches derartige Szenarien auf Basis des vorgestellten Prinzips ermöglicht, ist das Message Queue Telemetry TransportProtokoll (MQTT-Protokoll), welches bereits eine weitreichende Verbreitung im Hobby-Bereich sowie in der Umsetzung smarter Automatisierungslösungen genießt. Das MQTT-Protokoll übernimmt hierbei den Ansatz von Topics und erweitert diesen mittels Topic-Strukturen, unter deren Verwendung sich Informationsquellen in einer hierarchischen Art und Weise modellieren lassen. Mögliche Topics im Anwendungsfall eines Smart Home könnten dabei in etwa sein:

# mein_haus / erdgeschoss / wohnzimmer / temperatur_sensor # mein_haus / erdgeschoss / esszimmer / licht_sensor # mein_haus / erdgeschoss / kueche / temperatur_sensor # mein_haus / erdgeschoss / kueche / kuehlschrank / temperatur_sensor # mein_haus / erste_etage / schlafzimmer / temperatur_sensor

Sämtliche dieser Pfade repräsentieren dabei eine eindeutige Datenquelle und können nun von Konsumenten, beispielsweise einem Smartphone oder einem Server, abonniert werden. Die Subskribierung mehrerer Topics kann dabei über sogenannte Wild-Card-Ausdrücke vereinfacht werden. So würde der Ausdruck

mein_home / erdgeschoss / + / temperatur_sensor

sämtliche Temperatur-Sensoren in beliebigen Räumen des Erdgeschosses abonnieren. Im Rahmen jeder MQTT-Nachricht werden neben den reinen Nutzdaten (Payload), in diesem Fall z. B. der Temperatur-Wert, ebenso das jeweilige Topic mitgesendet wird. So kann der Daten-Konsument die Informationen einfach zuordnen (z. B. hinsichtlich des Ortes der Messung) und sinnvoll weiterverarbeiten.

Entstehung von Industrial Big Data in der Produktion

Ähnlich zum vorangegangenen Beispiel aus der smarten Heimautomatisierung, ließe sich die Akquise von Informationen in der Fabrik ebenso mit einem verhältnismäßig überschaubaren Aufwand realisieren. Die technischen Voraussetzungen, die hierzu erforderlich sind, lassen sich hierbei bereits heute bei einem großen Teil der vorhandenen Anlagen umsetzen. Aufgrund der Vielzahl der vorliegenden Informationsquellen – man stelle sich jeden Sensor und Aktor in der Fabrik als eigene "Quelle" vor – nimmt die Menge der in der Folge verfügbaren Informationen damit elementar zu. Hierdurch stellen sich wiederum neue Herausforderungen an die erforderliche Verarbeitung und Speicherung dieser Informationen, welche aufgrund der ständigen Generierung neuer Daten in der Regel kontinuierlich geschehen muss. Ist die Frequenz, in der diese Daten generiert werden, entsprechend hoch, stellen nicht nur die Datenmengen, sondern ebenso die Geschwindigkeit der eingehenden Informationen eine Herausforderung dar. Hinzu kommt die hohe Diversität der aus zumeist heterogenen Quellen stammenden Informationen.

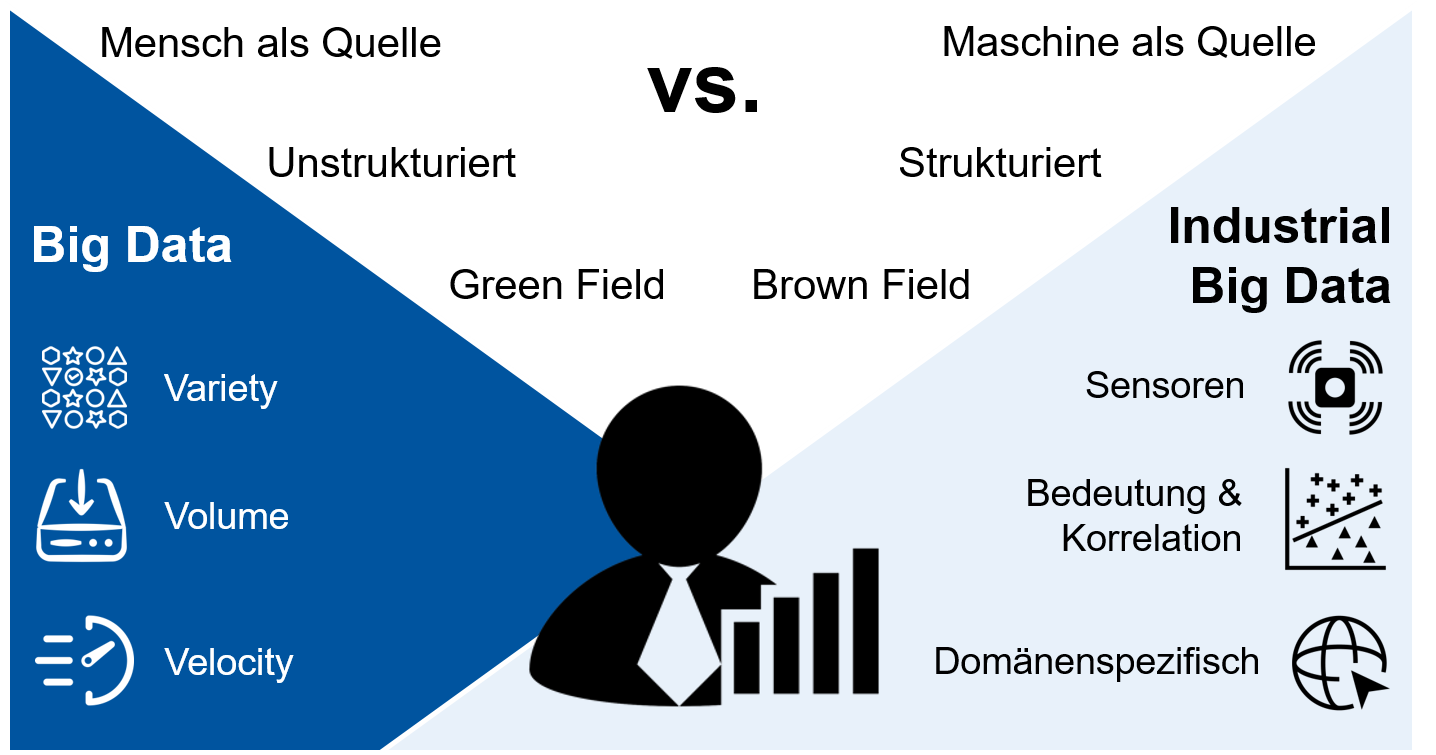

Die genannten Schwierigkeiten, die demnach mit einer massenhaften Generierung von Daten in datenintensiven Umgebungen einhergehen, werden im Kontext von Big Data treffenderweise unter den sogenannten "3 Vs" zusammengefasst, welche für "Volume", "Velocity" und "Variety" stehen, und in etwa mit "Größe", "Geschwindigkeit" und "Verschiedenartigkeit" übersetzt werden können. Die Komplexität beim Umgang mit Big Data ergibt sich dabei erst aus der Kombination der genannten Eigenschaften. Es ist nicht nur die reine Datenmenge, die ständig zunimmt, sondern diese Daten werden vor allem in immer kürzeren Zyklen generiert und sind aufgrund der Vielzahl der Quellen ebenso zunehmend verschiedenartiger. Diese Kombination von Herausforderungen erfordert zunehmend neuartige Konzepte und Strategien, um die Daten in der notwendigen Zeit zielführend verarbeiten zu können. Es sind also vielmehr diese neuartigen Ansätze und Methoden, die den Charakter des Big-Data-Begriffs definieren, als einfach nur das Vorhandensein großer Datenmengen, denn dies ist wie oben aufgeführt nur ein Aspekt.

Rund um die genannten Konzepte zur Verarbeitung von Big Data haben sich dabei innerhalb der vergangenen Jahre sogenannte "Big-Data-Ökosysteme" entwickelt, die domänenspezifisch und auf den jeweiligen Anwendungszweck angepasst, dazu in der Lage sind, der Heterogenität der Daten in einer angemessenen Zeit Herr zu werden. Diese Ökosysteme spiegeln sich in Infrastrukturen wider, die alle erforderlichen Komponenten zur Verarbeitung von Big Data beinhalten, also beispielsweise Technologien, die das verteilte Speichern von Informationen auf Rechner-Clustern ermöglichen, oder aber Dienste, die eine Orchestrierung von Analyse- oder Verarbeitungs-Jobs in einem verteilten Netzwerk realisieren. Weitere Komponenten mögen Abstraktionsschichten für einen Daten(bank)zugriff sein, oder Visualisierungsdienste zur Bereitstellung von Dashboards oder Kennzahlen-Cockpits. Derartige Big-Data-Ökosysteme sind im Bereich der traditionellen Big Data bereits dementsprechend ausgereift, im Bereich der Industrial Big Data fehlt es hier jedoch noch an den entsprechenden Standards. Die derzeitigen Schwierigkeiten bei der Umsetzung von Industrial-Big-Data-Lösungen werden treffend in Abb. 3 zusammengefasst.

Während "traditionelle" Big Data, wie sie zum Beispiel im World Wide Web vorzufinden sind, zumeist menschengemacht und dementsprechend unstrukturiert sind, lassen sich im Industrial-Big-Data-Bereich in der Regel maschinell generierte und damit einer gewissen Struktur gehorchende Daten identifizieren. Im Unterschied zu Big-Data-Ökosystemen, die in ihrer Gestaltung relativ frei von Restriktionen (Green Field) sind, sind mögliche Industrial-Big-Data-Lösungen jedoch stark durch den Brown-Field-Charakter bestehender Systeme und Anlagen charakterisiert. Dies bedeutet konkret, dass Lösungen im Industrial-Big-Data-Bereich zumeist im Einklang mit existierenden IT-Systemen, Anlagen und Steuerungen geschaffen werden müssen, was bedeutend größere Aufwände mit sich bringt. Eine dieser real existierenden Restriktionen besteht zum Beispiel in einer mangelhaften Auslegung von Netzwerkkapazitäten, wie sie in vielen Fabriken vorzufinden ist.

Zur Lösung dieser Problematik sind eine integrale Komponente der Industrial-Big-Data-Ökosysteme insbesondere im industriellen Kontext sogenannte Message-Queuing-Systeme, die ein Vorhalten von Informationen, z. B. Nachrichten, für die spätere Verarbeitung ermöglichen. Diese haben das Ziel, einen Datenverlust selbst bei einer möglichen Überlastung von Netzwerken zielsicher zu vermeiden. Die Auslegung eines derartigen Puffers ist in industriellen Umgebungen notwendig, da vorhandene Netzwerktechnologien oftmals auf älteren Standards basieren und zumeist Netzwerkgeschwindigkeiten im Bereich von 20 Mbit/s oder ähnlich vorzufinden sind. Die zielführende Gestaltung eines Datenpuffers sorgt hierbei dafür, dass selbst bei einem erforderlichen Neustart von Systemen oder einer anderweitigen Störung keine Daten verlorengehen.

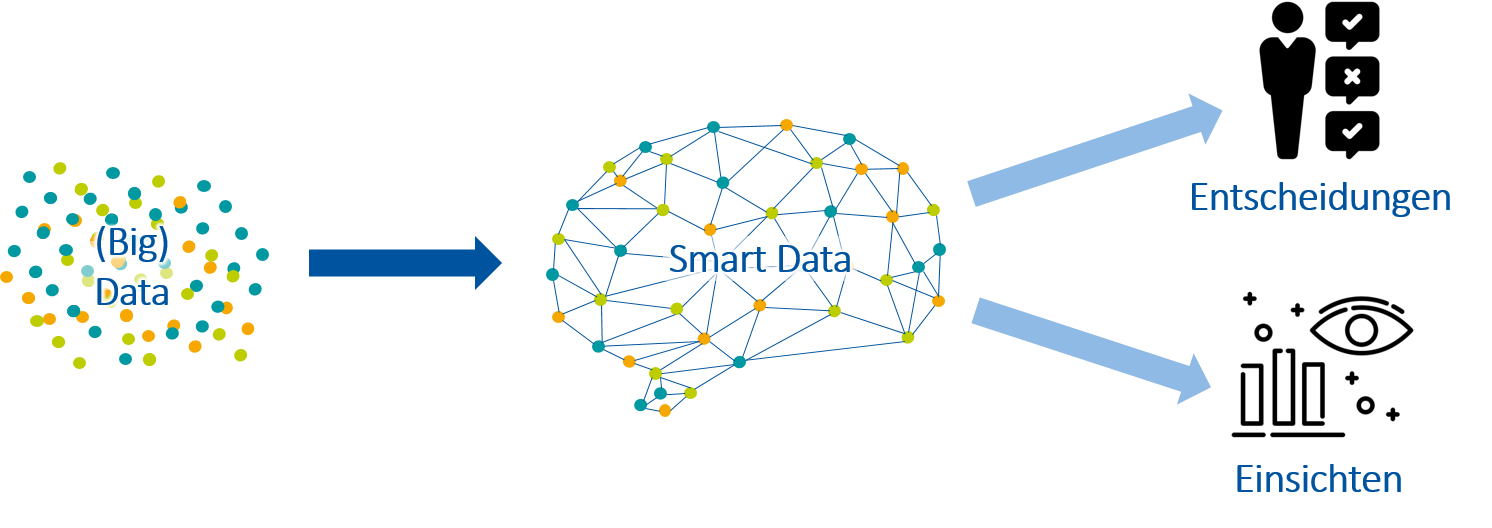

Neben den Technologien, die das reine Management von Big Data im industriellen Kontext zum Ziel haben, beinhalten Industrial-Big-Data-Ökosysteme desweitern sogenannte semantische Technologien, die eine Weiterverarbeitung von Informationen aus dem Feld ermöglichen. Der Begriff Semantik beschreibt hierbei eine strukturierte Vorgehensweise, die Daten mit kontextuellen Meta-Informationen zu versehen, wie oben beschrieben beispielsweise mittels OPC-UA-Informationsmodellen. Die Anreicherung der Daten mit Kontextinformationen dient der Vorverarbeitung der Informationen für die spätere datengetriebene Analyse. Wurden die Daten im Vorfeld also bereits mittels semantischer Technologien wie OPC UA oder Topic-basierten Verfahren wie MQTT gesammelt, können unsere integrierten Big Data somit in sogenannte "Smart Data", also für die intelligente Analyse verwendbare und interpretierbare Daten, überführt werden.

Wie in Abb. 4 schematisch dargestellt, lassen sich darauf basierend datengetriebene Verfahren anwenden, zum Beispiel zur Schaffung von Entscheidungsunterstützungssystemen (Decisions) oder aber für den strukturierten Erkenntnisgewinn.

Anwendungsbereiche von Industrial Big Data in der intelligenten Produktion

Die Anwendungsbereiche von Industrial Big Data in der Produktion sind vielfältig. Eines der wichtigsten und wirtschaftlich interessantesten Gebiete liegt jedoch in der datengetriebenen Vorhersage von Maschinen- und/oder Produktzuständen. Eine besondere Bedeutung kommt beispielsweise der Vorhersage notwendiger Wartungen zu (Predictive Maintenance) oder aber der Antizipation von Produktzuständen (Predictive Quality). Letztere lassen sich mithilfe sogenannter Prädiktionsmodelle vorhersagen und dienen beispielsweise einer frühzeitigen Klassifikation eines Produktes in die Klassen "OK" oder "Mangelhaft". Die Klasse "Mangelhaft" lässt sich dabei zumeist noch in weitere Unterklassen aufteilen, die beispielsweise auf die Ursache der mangelnden Qualität des Endprodukts hinweisen.

Bei Vorlage der entsprechenden Datengrundlage werden derartige Klassifikations-/Prädiktionsmodelle auf Basis sogenannter "Muster", oder auch "Pattern", welche sich in den Daten identifizieren lassen, abgebildet. Muster entstehen dabei durch den Vergleich verschiedener Eingangsparameter und Messgrößen mit historischen Daten, welche mit den entsprechenden Klassen bezeichnet sind. Je vielseitiger und genauer die vorhandenen Daten sind, desto zielsicherer lassen sich in der Folge die entsprechenden Klassen vorhersagen und eine genaue Fehleranalyse durchführen, noch bevor das Produkt überhaupt seinen finalen Zustand erreicht. Ziel ist hierbei die Realisierung sogenannter geschlossener Feedback-Loops, bei dem Erkenntnisse, die kontinuierlich aus den Produktionsdaten gewonnen werden, in den Prozess zurückgespielt werden, um die Fertigungssystematik langfristig zu verbessern.

Digitale Transformation in der Praxis

Die praktische Realisierung der innerhalb dieses Artikels vorgestellten "digitalen Wertschöpfungskette" ist ein langwieriger Prozess und hängt stark von den jeweiligen Randbedingungen der gewachsenen Produktionsstätte ab. Trotzdem ist es möglich, bei Vorhandensein der entsprechenden Grundkenntnisse prototypische Lösungen und erste Ansätze zur Realisierung von Industrial Big Data in der eigenen Produktion unter überschaubarem Aufwand umzusetzen.

Der Autor des vorliegenden Artikels bietet entsprechend dieser Grundlagen Seminare und Trainings für die erfolgreiche Transformation der eigenen Produktion an.