Die Zukunft der KI beginnt mit der richtigen Infrastruktur

Die jüngsten Fortschritte in der generativen KI haben KI und ML in den Fokus der meisten Unternehmen gerückt. KI wird zunehmend Mainstream. Das Training von KI-Modellen und die Verarbeitung von KI-Workloads stellen allerdings hohe Anforderungen. Unverzichtbar sind deshalb leistungsstarke KI-Infrastrukturlösungen, in denen das Netzwerk eine Schlüsselrolle einnimmt.

Eine Welt, in der Maschinen den Menschen nicht nur verstehen, sondern ihm auch helfen können, ganze Branchen zu revolutionieren – das ist keine Science Fiction mehr, sondern die Realität der Künstlichen Intelligenz.

Von der Art und Weise, wie wir mit Smartphones interagieren, bis hin zu bahnbrechenden wissenschaftlichen Entdeckungen und Unternehmensanwendungen nimmt der Einfluss von KI immer weiter zu. Möglich wird dies durch Innovationen bei der KI-Hardware- und Software-Infrastruktur sowie bei Large Language Models (LLMs). Die KI-Infrastruktur, insbesondere die Vernetzung, ist dabei von entscheidender Bedeutung.

Der KI-Lifecycle: Vom Training zur Inferenz

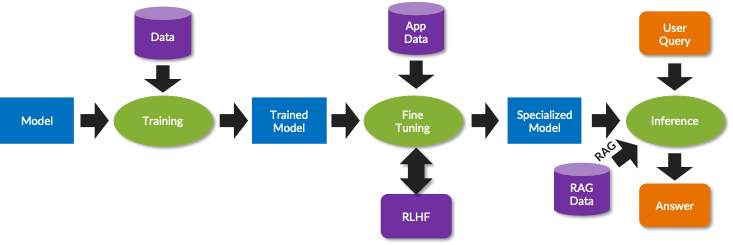

Der Kern des KI-Lebenszyklus beginnt mit dem Training. Im Gegensatz zum traditionellen Computing, bei dem Programme einer vorkodierten Logik folgen, lernen Anwendungen der generativen KI die Logik aus umfangreichen Datensätzen, die während der Trainingsphase in ein LLM eingespeist werden. Dieser Prozess umfasst neuronale Netze, die den Neuronen im menschlichen Gehirn ähneln und mathematische Funktionen (Aktivierungsfunktionen) auf die gewichtete Summe ihrer Inputs (Parameter) anwenden, um Outputs zu generieren. Mit Hilfe von GPUs und XPUs werden große Datenmengen – die Outputs – zwischen den Knoten eines neuronalen Netzes ausgetauscht, wodurch das Netz zu einem integralen Bestandteil der KI-Infrastruktur wird.

Nachdem die Modelle mit generischen Daten trainiert wurden, werden sie mit anwendungsspezifischen Daten fein abgestimmt, um die Genauigkeit, Relevanz und Effektivität zu verbessern. Häufig wird dabei "bestärkendes Lernen durch menschliche Rückkopplung" (Reinforced Learning from Human Feedback – RLHF) eingesetzt, um Verzerrungen und Halluzinationen zu beseitigen. Das spezialisierte Modell verwendet optional Retrieval Augmented Generation (RAG), um die Exaktheit und Aktualität der Informationen zu optimieren, die für die Inferenz verwendet werden.

Der KI-Stack: So funktioniert die KI-Infrastruktur

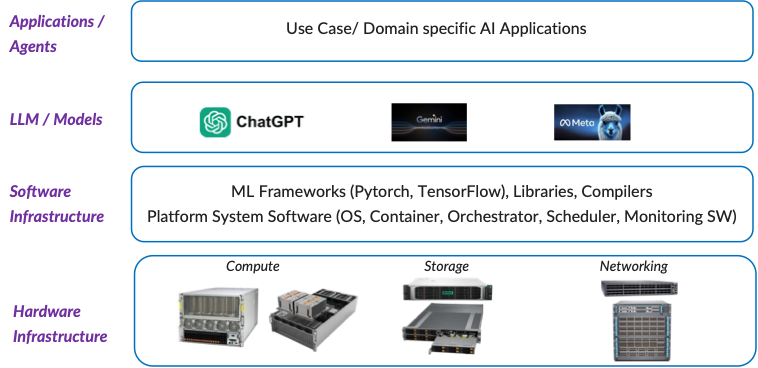

Ein effektiver KI-Lösungs-Stack besteht aus mehreren Schichten, die alle für die Gesamtfunktionalität entscheidend sind. An der Spitze stehen KI-Anwendungen und -Agenten, die anwendungs- und domainspezifische Funktionen bereitstellen. Diese bauen auf LLMs wie ChatGPT, Gemini oder Llama auf, die in der Lage sind, menschliche Sprache zu verstehen und darauf zu reagieren, indem sie große Datensätze an Text, Bildern, Audio und Video verarbeiten.

Unterstützt werden diese Anwendungen durch eine robuste Software-Infrastruktur, einschließlich ML-Frameworks wie PyTorch oder TensorFlow. Diese Frameworks bieten wichtige Tools für die einfache Entwicklung und das Training von Modellen – in Kombination mit Bibliotheken und Compilern wie NumPy, die für Matrixoperationen für bestimmte GPUs/XPUs optimiert sind. Außerdem wird eine Plattform-Systemsoftware benötigt, die Betriebssysteme, Container, Orchestratoren, Clustering-Software, Scheduler und Monitoring-Software umfasst, um den ML-Lebenszyklus zu verwalten und zu automatisieren.

Die Hardware-Infrastruktur mit Computing, Storage und Netzwerk bildet das Fundament für den KI-Stack. Im Bereich Computing betrifft es KI-Server mit Beschleunigern (GPUs/XPUs), CPUs, High Bandwidth Memory (HBM) und Hochleistungs-Netzwerkschnittstellen. Speichersysteme werden verwendet, um die GPUs/XPUs mit Daten zu versorgen und Zwischenergebnisse zu überprüfen, um Ausfälle zu verhindern. Die GPUs/XPUs in diesen Servern laden das Modell und die Daten in den HBM, führen mathematische Operationen aus und erzeugen Ergebnisse. Diese werden dann zwischen den GPUs/XPUs über ein hochskalierbares Netzwerk mit niedriger Latenz ausgetauscht. Während der Trainingsphase wiederholt sich dieser Rechen- und Kommunikationszyklus über Tage bis zu Wochen.

Die Bedeutung des Netzwerks im KI-Kontext

Das Netzwerk spielt in solchen KI-Clustern eine entscheidende Rolle, da es die für KI-Workloads erforderliche verteilte Architektur bereitstellt. Heute machen dabei KI-Server über 80 Prozent der Gesamtkosten der KI-Infrastruktur aus. Verzögerungen bei der Netzwerkkommunikation können zu einer Unterauslastung teurer KI-Server führen, was sich auf die Gesamtperformance und Kosteneffizienz auswirkt. Dies unterstreicht die Notwendigkeit eines hochleistungsfähigen Netzwerks mit geringer Latenz, um die Job Completion Time (JCT) zu verringern und die Performance von KI-Anwendungen zu steigern.

Da das KI-Training extrem rechenintensiv ist und ohne eine Scale-Out-Architektur nicht bewerkstelligt werden kann, verwenden KI-Algorithmen Parallelitätstechniken. Dabei wird eine Kombination aus Datenparallelität (Aufteilung der Daten auf mehrere GPUs/XPUs) und Modellparallelität (Aufteilung der Modellberechnung auf mehrere KI-GPUs/XPUs) für die Performance-Effizienz verwendet. Bei diesem Ansatz müssen die KI-Server in regelmäßigen Abständen über das Netzwerk kommunizieren, was als Gradient Exchange bekannt ist, und warten, bis die Kommunikation in jeder Phase abgeschlossen ist.

Die Nutzung der Parallelität erfordert einen umfassenden Datenaustausch während des Trainings mittels Remote Direct Memory Access (RDMA). Dies führt zu massiven und komplexen Datenströmen, den so genannten "Elephant Flows", und zur Überlastung des Netzwerks. Ein Lossless Network mit fortschrittlichen Load-Balancing- und Congestion-Management-Funktionen ist folglich für die Aufrechterhaltung der Effizienz, Performance und Zuverlässigkeit von KI-Clustern von zentraler Bedeutung.

Da das Training von KI-Modellen mit der Nutzung großer Datenmengen verbunden ist, die effizient gespeichert und abgerufen werden müssen, ist das Checkpointing – die Erstellung regelmäßiger Snapshots des Trainingsfortschritts des Modells – wichtig für die Resilienz gegenüber Hardwareausfällen. Außerdem bietet es die Möglichkeit zum Experimentieren und stellt einen Mechanismus zur Erleichterung der Fehlersuche bereit.

Die Erstellung regelmäßiger Snapshots des Trainingsfortschritts des Modells ist wichtig für die Resilienz gegenüber Hardwareausfällen.

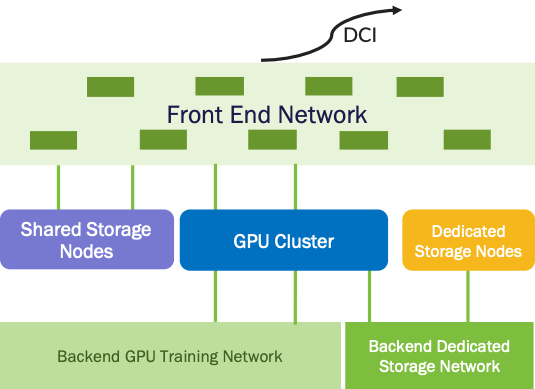

KI-Cluster verfügen in der Regel über mehrere Netzwerke, die jeweils unterschiedlichen Zwecken dienen. Das Frontend-Netzwerk verbindet den KI-Server mit dem Rest des Rechenzentrums und der Außenwelt und hilft den Benutzern, sich mit dem KI-Cluster zu verbinden. Das Data Center Interconnect (DCI) verknüpft mehrere Rechenzentren, in denen KI-Cluster vorhanden sind, um eine hohe Verfügbarkeit und Ausfallsicherheit zu gewährleisten, und das Scale-Out-Netzwerk wird für den Gradient Exchange während des Trainings verwendet. Das Backend-Storage-Netzwerk kombiniert die KI-Server mit Hochleistungsspeichern. Die Anwender bevorzugen dabei Ethernet. Schließlich verbindet das Scale-up-Netzwerk mehrere KI-Server innerhalb eines Gehäuses oder eines Racks mit einem Cache-kohärenten, herstellerspezifischen Netzwerk mit hoher Bandbreite wie NVLink für Nvidia und Infinity Fabric für AMD. Kürzlich wurde zudem eine auf offenen Standards basierende Alternative namens Ultra Accelerator Link (UALink) mit breiter Unterstützung der Industrie entwickelt.

DevOps auf den diesjährigen IT-Tagen

Spannende Vorträge und Workshops zum Thema DevOps erwarten Euch auch auf den IT-Tagen, der Jahreskonferenz von Informatik Aktuell. Die IT-Konferenz findet jedes Jahr im Dezember in Frankfurt statt – dieses Jahr vom 08.-11.12.

Fazit: Die beschleunigte KI-Innovation

Die Branche steckt noch in den Kinderschuhen, entwickelt sich aber rasch weiter und investiert laufend in die Verbesserung der Genauigkeit, Performance und Energieeffizienz von KI-Modellen. Durch viele Investitionen in Bereiche wie erweitertes Datenmanagement, Modelloptimierung oder -auswahl und kontinuierliches Lernen wird versucht, die Exaktheit zu erhöhen. Optimierungen bei Modellen (zum Beispiel durch Quantisierung, Pruning oder Destillation), Algorithmen, Software (beispielsweise Bibliotheken und Frameworks) und Hardware (zum Beispiel Server, Speicher, Netzwerke und Optik) zielen außerdem darauf ab, die Leistung weiter zu steigern und die Energieeffizienz zu verbessern.

Abgesehen von den technologischen Erwägungen ist die Gewährleistung der ethischen Nutzung von KI und die Verhinderung ihres Missbrauchs ein wichtiger Schwerpunkt. Industriekonsortien wie MLCommons, UALink, das Ultra Ethernet Consortium und andere Projekte wie PyTorch und Triton werden hier eine wichtige Rolle bei der Förderung von Zusammenarbeit und Innovation spielen – und dabei auch den vorhandenen Vorbehalten und konkreten Anwenderbedürfnissen Rechnung tragen.