Oracle 12c RAC auf IBM Power8 Plattform

Mit New Power Systems built with POWER8 architecture and processor liefert IBM die neueste Generation ihrer Power Platform aus. Rolf Abramowski hat Oracle 12c Real Application Clusters (RAC) auf dem neuen Power8 getestet.

Ausgelegt für Big Data, Analytics und Cloud Computing, optimiert im Bereich CPU, Memory und I/O, zudem laut Hersteller sowohl horizontal als auch vertikal extrem skalierbar: Mit dem POWER8-Prozessor und der entsprechenden Architektur will IBM einen neuen Standard im Bereich Unix Server setzen. Dabei sollen auch Applikationen wie beispielsweise SAP von der neuen Leistungsbandbreite profitieren.

Anwendungen können mit dem Power8-Prozessor durch SMT8 bis zu 8 Hardware Threads pro Prozessorkern nutzen. Hardwareunterstützung zur Optimierung von Java-Code wird ebenso geliefert wie eine effiziente Energieverwaltung, neue PCI Gen3 Devices und On-Chip/In-Core-Verschlüsselung. Das Coherent Accelerator Processor Interface (CAPI) Protokoll ermöglicht eine schnelle Bereitstellung von Informationen.

Der Power8-Prozessor ist der erste Prozessor, der Little-Endian und Big-Endian gleichwertig unterstützt. Little-Endian (LE) Betriebssysteme können als PowerKVM-Gast eingesetzt werden – mit der Einschränkung, dass alle PowerKVM-Gäste im selben Modus laufen müssen. Hier ist allerdings eine gleichzeitige Unterstützung von LB und BE ebenso geplant wie der Support für LE auf PowerVM. Damit wird es aber möglich, auf demselben physikalischen Server LE sowie BE Betriebssysteme in getrennten LPARs (Logical Partitions) zu fahren.

Wir testen eine Oracle 12c Grid Installation mit ASM auf zwei AIX LPAR’s unter einem IBM Power System S824. Auf beiden LPARs ist der neuste AIX Fixstand installiert: 7100-03-03-1415. Beide Cluster-Knoten laufen als uncapped Shared SMT8 mit einem Entitlement von 1.00 und 60 GB Memory.

Mit smtctl kann der aktuelle SMT Status angezeigt werden und ebenso dynamisch geändert werden (Ausschnitt):

Eine Änderung kann im laufenden Betrieb erfolgen, so dass entsprechende Performance Tests schnell durchgeführt werden können:

Die Installation der Oracle Grid Infrastructure und von Oracle Real Application Clusters (RAC) mit der Version 12c lässt sich ohne weitere Oracle Patches problemlos ausführen. Der Oracle Universal Installer prüft die Installationsvoraussetzungen und kann fehlende Einstellungen nachholen. So benötigt die Oracle Cluster-Installation eine SSH-Verbindung zwischen den einzelnen Clusterknoten. Der Oracle Installer unterstützt hier beispielsweise die Konfiguration.

Oracles Scripte verwenden im Hintergrund die Bash als auszuführende Shell. Diese ist standardmäßig unter AIX nicht installiert; die Korn Shell ist hier der Standard. Vor der Installation der Oracle-Software sollte man daher die Bash installieren. Alternativ muss man die erforderlichen Einstellungen manuell durchführen.

Oracle Database 12c bietet eine neue Option: Oracle Multitenant. Sie soll die Konsolidierung von Datenbanken vereinfachen, ohne dass Änderungen an bestehenden Anwendungen erforderlich sind. In dieser neuen Architektur können in einer Multi-Tenant-Containerdatenbank mehrere austauschbare Datenbanken, die Pluggable Databases (PDBs), gehostet werden. Schon bei der Installation der Datenbank oder auch später im Nachgang der Installation kann man diese PDBs erzeugen.

Storage im Oracle Real Application Cluster

Oracle-Datenbanken bringen mit Automatic Storage Management (ASM) einen eigenen Volumemanager und ein Dateisystem für Datenbanken mit, das im Cluster von allen Knoten gemeinsam genutzt werden kann. Basis ist ein gemeinsamer Storage, beispielsweise im SAN, auf den alle Clusterknoten zugreifen können. ASM erlaubt Stripping und Mirroring. Es wurde für Datenbankzugriffe optimiert.

Unter AIX gibt es zwei interessante Möglichkeiten, die für ASM benötigte Disk eindeutig zu kennzeichnen und zu schützen. Zuerst muss beachtet werden, dass die Namen der shared Disk auf den beteiligten Knoten nicht identisch sein müssen. Plattennamen werden unter AIX lediglich im ODM (Object Data Manager) geschrieben und nicht hart codiert auf den Platten selbst.

Um die eindeutige Zuordnung der Platten zu gewährleisten, könnte man sich der PVID bedienen, die mit dem chdev-Kommando gesetzt werden kann und im Offset 80 der Platte geschrieben steht. lspv –u ist hier eine bessere Möglickeit, da eindeutige Merkmale wie UUID und WW Name angezeigt werden, die auf allen beteiligten Knoten identisch sind:

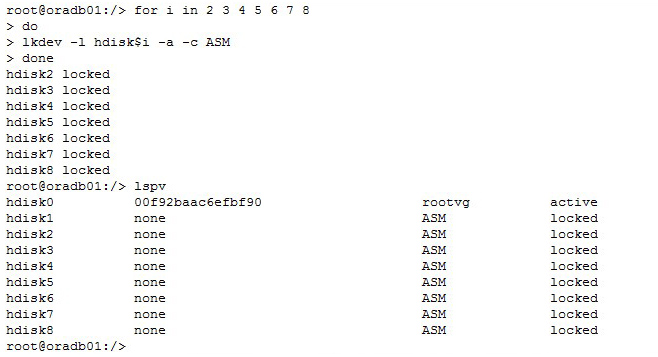

Mit rndev und lkdev stehen uns zwei weitere Kommandos zur Verfügung. Durch rndev können Geräte umbenannt werden. Aber Achtung: Das muss auf allen beteiligten Knoten durchgeführt werden. Interessanter ist aber lkdev: Hiermit kann die ASM Disk vor Veränderungen durch die Befehle chdev, chpath, rmdev und rmpath geschützt werden. Außerdem kann man einen Text zur Kennzeichnung mitgeben:

FlexASM

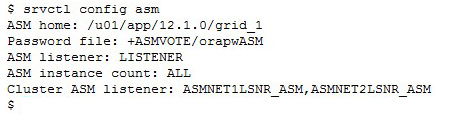

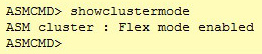

FlexASM ist eine neue Funktionalität im Oracle-Cluster, die jedoch nur für Oracle 12c-Datenbank-Instanzen nutzbar ist. Mit FlexASM ist keine lokale ASM-Instanz mehr erforderlich. Damit ist ASM auf dem lokalen Knoten auch kein “Single-Point-of-Failure” (SPOF) mehr. Gibt es eine lokale ASM-Instanz, nutzt die Oracle-Instanz diese, ansonsten verbindet sie sich mit einer ASM-Instanz auf einem anderen Knoten. Mit Oracle 12c führt ASM auch neue Cluster-Ressourcen ein: Das ASM-Netzwerk, den ASM-Listener und den ADVM-Proxy.

Bei der Installation der Grid Infrastructure wählen wir das mit Oracle 12c neu eingeführte Feature „Use Oracle Flex ASM for storage“ (Oracle Flex ASM). Es werden nun statt 63 bis zu 511 ASM Disk Groups unterstützt und die LUN Größe für Oracle Database 12c Clients kann bis zu 32PB betragen.

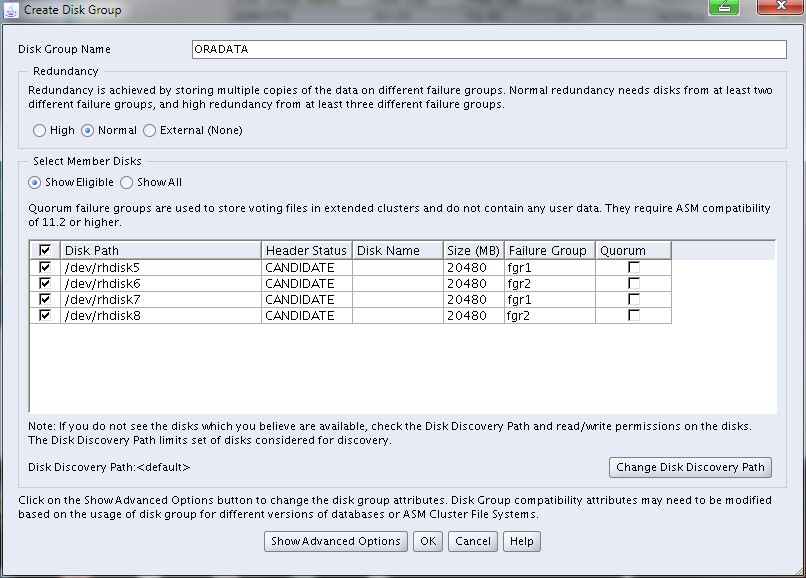

Nun können die entsprechenden Diskgroups erstellt werden (hier die Diskgroup für die Votingfiles):

Mit Oracle 12c muss nicht mehr - wie in früheren Oracle-Releases - jeder Cluster Node eine eigene gestartete ASM Instanz vorhalten. Weitere Konfigurationen sind nicht nötig, können aber auch später noch ausgeführt werden. So kann beispielsweise die Anzahl der verwendeten ASM-Instanzen konfiguriert werden. Fällt eine ASM Instanz aus, so startet Oracle Clusterware automatisch eine Instanz auf einem anderen Node. Die Datenbankinstanz verbindet sich dann auf eine andere ASM-Instanz auf einem weiteren Server. Die Default ASM cardinality ist 3. Sie kann über Befehle der Clusterware geändert werden.

JFS2 Storage

Netzwerkadressierung im Oracle12c RAC

Das mit Oracle Real Application Clusters (RAC) 11g Release 2 eingeführte Oracle Single Client Access Name (SCAN) Feature erfährt in Oracle RAC 12c einige Erweiterungen. SCAN ermöglicht Clients durch einen einzelnen Namen auf den Oracle Cluster zuzugreifen. Damit ergibt sich die Möglichkeit, innerhalb des Clusters Knoten hinzuzufügen oder zu entfernen, ohne in den Verbindungskonfigurationen der Clients Änderungen vornehmen zu müssen. Clients können mit Hilfe von EZConnect oder einer einfachen JDBC thin URL auf jede Datenbank im Cluster zugreifen, unabhängig davon, auf welchem Server die Datenbank aktiv ist. Dabei bietet die Installation von Oracle Grid zwei Möglichkeiten: SCAN kann innerhalb der unternehmenseigenen DNS Infrastruktur benutzt werden oder mit Hilfe von Oracle Grid Naming Services (GNS). Im ersten Fall werden über DNS dem eindeutigen Namen 3 IP-Adressen zugeordnet, die im round-robin Verfahren an die Clients weitergegeben werden und so eine Lastverteilung ermöglichen. Clients ab der Version Oracle 11g Release 2 können diesen Mechanismus auch im Failover-Fall ohne spezielle Konfiguration nutzen. Wird Oracle Grid Naming Service (GNS) benutzt, werden für den Cluster Service 3 IP-Adressen vom DHCP-Server bezogen oder über „Stateless Address AutoConfiguration“ (SLAAC) im Falle von IPv6 um die benötigten Adressen für SCAN im öffentlichen Netz zur Verfügung zu stellen. Mit Oracle Grid Infrastructure 12c Release 1 werden folgende Erweiterungen zur Verfügung gestellt:- SCAN und Oracle Clusterware managed VIPs unterstützen IPv6 Adressen

- SCAN registriert standardmäßig nur noch Services, die von Cluster Knoten kommen

- SCAN bietet Unterstützung für verschiedene Subnets im Cluster (ein SCAN per Subnet)

- Erstellen zusätzlicher Subnetze als public network.

- Erstellen der Knoten-VIPs in den Subnetzen.

- Es werden die Knoten-Listener erstellt

- Es wird ein SCAN mit den obigen Optionen erstellt

Netzwerkoptionen

CRSCTL

- Starten und Stoppen der Oracle Clusterware Ressourcen

- Starten und Stoppen der Oracle Clusterware Daemons

- Health Check auf dem Cluster

- Ressourcen, die third-party-Applikationen repräsentieren, steuern

- Integrating Intelligent Platform Management Interface (IPMI)

- Debuggen von Oracle Clusterware Komponeneten

>

<

!=

co: Contains

st: Starts with

en: Ends with Ein Beispiel: