GenAI in der Praxis

Wie Unternehmen GenAI erfolgreich in ihre Produkte integrieren

Die Integration von generativer Künstlicher Intelligenz (GenAI) in moderne Produkte hat das Potenzial, die Art und Weise, wie wir Technologie nutzen und erleben, grundlegend zu verändern. GenAI ermöglicht es, auf Basis bereits existierender Modelle Texte, Bilder, Code und vieles mehr zu generieren, was zu einer erheblichen Effizienzsteigerung und Innovation in verschiedenen Branchen führen kann. Durch die Nutzung dieser Technologien können Unternehmen ihre Produkte und Dienstleistungen personalisieren, die Benutzererfahrung verbessern und neue Geschäftsmöglichkeiten erschließen.

In diesem Artikel konzentrieren wir uns auf den praktischen Einsatz bereits existierender GenAI-Modelle in eigenen Anwendungen, geben Hinweise zur Bewertung von Anwendungsszenarien und zeigen technische Optionen zur Integration auf.

- Komplexe Prozesse optimieren mit GenAI: Anwendungsszenarien im Überblick

- Integration von GenAI: Bedingungen und Restriktionen

- Risiken und der abgeleitete Entwicklungsprozess

- Entwicklungsprozess für GenAI-Integration

- Erfolgreiche Integration von GenAI: Architekturüberlegung & Tooling

- Optimierung der Maschinenparametrierung mit GenAI: Use Case aus der Praxis

- Fazit

Wenn wir nachfolgend von GenAI sprechen, so beziehen wir uns auf die Nutzung bereits trainierter, existierender Modelle (Large Language Models oder LLM) zur Generierung von Texten, Bildern, Code und anderen Inhalten. Der Fokus liegt dabei nicht auf dem Training eigener Modelle, sondern auf der Integration von vorgefertigten Lösungen in das eigene Produkt. Dies ermöglicht es Unternehmen, schnell und effizient von den Vorteilen der GenAI zu profitieren, ohne die hohen Kosten und den Aufwand des Modelltrainings auf sich nehmen zu müssen.

Zu Beginn eines jeden Projektes steht die Definition von Projektziel und erwartetem Mehrwert. Für den Einsatz von GenAI gilt dies umso mehr, denn neben all dem Hype und den Hoffnungen rund um den Einsatz von GenAI gibt es auch immer wieder Enttäuschung und Ernüchterung. Daher betrachten wir einleitend Szenarien und Anwendungsfälle, die sich für den Einsatz von GenAI besonders eignen, sowie Erfolgsparameter, Bedingungen, Restriktionen und Risiken, die für eine erfolgreiche Integration wichtig sind.

Komplexe Prozesse optimieren mit GenAI: Anwendungsszenarien im Überblick

Die rasante Entwicklung generativer Künstlicher Intelligenz eröffnet neue Möglichkeiten in zahlreichen Branchen. Durch den Einsatz existierender Modelle können Unternehmen komplexe Prozesse optimieren und innovative Lösungen entwickeln. Beispiele hierfür sind die Automatisierung von Lieferketten, die Optimierung von Produktionsabläufen in der Fertigungsindustrie, die Vorhersage von Wartungsbedarf im Maschinen- und Anlagenbau oder die Analyse von Transaktionsdaten im Finanzsektor. Unabhängig vom spezifischen Anwendungsbereich weisen die erfolgreich implementierten GenAI-Szenarien darauf hin, dass insbesondere in drei Bereichen ein hoher Wert zu erzielen ist.

Den ersten Bereich bilden Szenarien, die auf die Erlangung von Verständnis abzielen. Anwendungen aus diesem Bereich bedienen sich des vortrainierten Modells und zusätzlicher Daten, um für den Anwender die Fülle der Information kompakt und nutzbar zu machen. Beispiele hierfür sind Integrationen in CRM-Systeme, die Details und Aktivitäten zusammenfassen, automatisierte Meeting Notes in Microsoft Teams, automatisierte Zusammenfassungen von Nutzerbewertungen auf Shopping-Portalen oder Chatbots für den Kundenservice, wie sie auf vielen Webseiten zu finden sind [1]. Aber auch eher klassische, dokumentenorientierte Applikationen können von solchen Zusammenfassungen profitieren. So wie Microsoft Word oder Microsoft PowerPoint heute schon die Möglichkeit bieten, eine Zusammenfassung eines Dokuments zu generieren, so lassen sich solche Zusammenfassungen auch für z. B. technische Anwendung, Analyse- und Programmiersysteme und Ähnliches bereitstellen. Ein Hersteller eines Messgeräts könnte seine Mess-Software somit dazu bringen, dem Anwender mitzuteilen, welche Art von Messungen gemacht wurde, welche Rahmenparameter dabei zutrafen und was die wichtigsten Erkenntnisse aus der Messung sind. Und eine Konstruktionssoftware könnte beschreiben, was im aktuellen Projekt konstruiert wird und was beim Ausbau und Erweiterung der Konstruktion zu berücksichtigen wäre.

Der zweite Bereich von Szenarien umfasst Situationen, in denen das Modell Bestehendes verbessert. So verbessert zum Beispiel Microsofts Copilot in Outlook die Formulierung von E-Mails und passt sie an gewünschte Kommunikationsstile an [2]. Gleiches ist für Posts auf Social Media möglich. Dem ähnlich sind Optimierungen von Code unter Vorgabe bestimmter Optimierungsparameter. Visual Studio Code hat diese Funktionalität via GitHub Copilot bereits seit 2021. Werkzeuge für Grafiker wie z. B. Adobe Photoshop bieten Möglichkeiten, um mittels GenAI z. B. Hintergründe zu ersetzen oder Bilder zu erweitern [3]. Auch Konstruktions- und Planungssysteme können solche Verbesserungen anbieten.

Dem zweiten Bereich ähnlich ist der dritte Bereich, bei dem GenAI völlig neue Inhalte generiert. Ausgehend von Informationen zur Aufgabe, welche als Text, Code oder Bild vorliegen können, generiert das Modell neue Artefakte, die entweder direkt dem Nutzer zur Verfügung gestellt werden oder aber als Input für weitere Verarbeitungsschritte dienen. Werkzeuge für Entwickler wie GitHub Copilot oder Cursor sind hier sicher Vorreiter, aber auch Konstruktionswerkzeuge ziehen hier nach, wie Harting und Siemens auf der electronica 2024 zeigten [4].

Integration von GenAI: Bedingungen und Restriktionen

Bevor GenAI in bestehende Softwarelösungen integriert wird, müssen zunächst die grundlegenden Voraussetzungen geprüft werden. Entscheidend sind dabei qualitativ hochwertige, umfangreiche und repräsentative Datensätze, die als Basis für das Training und die kontinuierliche Optimierung der Modelle dienen. Eine stabile IT-Infrastruktur, die Integration in bestehende Workflows sowie klare Verantwortlichkeiten innerhalb des Unternehmens sind weitere essenzielle Bedingungen, um die Leistungsfähigkeit und Zuverlässigkeit von GenAI sicherzustellen.

Gleichzeitig gibt es diverse Restriktionen, die dem Erfolg des Einsatzes entgegenstehen können. Datenschutz- und Sicherheitsanforderungen, insbesondere im Umgang mit sensiblen oder personenbezogenen Daten, stellen häufig erhebliche Hürden dar. Auch regulatorische Vorgaben und ethische Bedenken, etwa in Bezug auf Bias und mangelnde Transparenz der Modelle, können den praktischen Einsatz einschränken. Technische Herausforderungen wie die Komplexität der Integration in bestehende Systeme und die oft begrenzte Erklärbarkeit der Ergebnisse verstärken diese Restriktionen zusätzlich.

Der Einsatz von GenAI erfordert einen ganzheitlichen Ansatz, der technische, organisatorische und rechtliche Aspekte berücksichtigt.

Außerdem ist die Kuratierung von Daten ein wichtiger Aspekt, um sicherzustellen, dass GenAI die benötigten Informationen hat. Dies umfasst die Handhabung von unstrukturierten und über verschiedene Silos verteilten Daten sowie die Implementierung von Qualitätskontrollen wie Rejection Sampling. Evaluierungen sind ebenfalls entscheidend, um die Antworten eines Modells zu messen und zu bewerten. Besonders herausfordernd sind dabei nicht-verifizierbare Domänen, d. h. Domänen, in denen es schwierig oder unmöglich ist, die Ergebnisse oder die Leistung eines Modells objektiv zu überprüfen oder zu validieren. In solchen Domänen fehlen oft klare, messbare Kriterien oder Benchmarks, um die Genauigkeit und Zuverlässigkeit der Ergebnisse zu bewerten.

Darüber hinaus existieren Szenarien, in denen der Einsatz von GenAI sorgfältig evaluiert werden muss. Dies gilt z. B. für sicherheitskritische Anwendungen, bei denen Fehlentscheidungen schwerwiegende Folgen haben können. Hierunter fallen insbesondere Szenarien aus der Medizintechnik oder der kritischen Infrastruktur. Auch für Anwendungen mit der Forderung nach geringen Latenzen und garantierten Antwortzeiten, wie sie z. B. im Maschinen- und Anlagenbau vorkommen, ist eine fundierte Bewertung und Evaluierung des Einsatzes von GenAI dringend geboten.

Letztlich erfordert der erfolgreiche Einsatz von GenAI einen ganzheitlichen Ansatz, der sowohl technische als auch organisatorische und rechtliche Aspekte berücksichtigt. Nur wenn die notwendigen Rahmenbedingungen geschaffen und die bestehenden Restriktionen adressiert werden – etwa durch robuste Sicherheitskonzepte, klare Compliance-Regelungen und die Schulung aller beteiligten Akteure – können die Potenziale von GenAI ausgeschöpft und nachhaltige Wettbewerbsvorteile erzielt werden.

Risiken und der abgeleitete Entwicklungsprozess

Unter Berücksichtigung der bislang vorgestellten Szenarien, der Restriktionen und der Bedingungen lässt sich direkt festhalten, dass nur ein agiles Vorgehen, mit kurzen Zyklen und vielen kleinen Experimenten sowie steter Kontrolle, unter Einbindung und direkter Zusammenarbeit von Domänenexperten, Technologiespezialisten und Anwendern, zu einer erfolgreichen Integration von GenAI in das eigene Softwareprodukt führen kann. In der Umsetzung müssen von Anbeginn Methoden und Prozesse vorgesehen werden, die Halluzinationen des Modells erkennen und verringern, Bias und Fehlinformationen identifizieren und die Möglichkeit zur Umkehr von GenAI-basierten Anpassungen und Änderungen erlauben. Dies gilt sowohl für den Zeitraum der Entwicklung, aber insbesondere auch für den Betrieb der Lösung.

Entwicklungsprozess für GenAI-Integration

Nachdem wir die Anwendungsszenarien, Bedingungen und Restriktionen sowie die Risiken der GenAI-Integration betrachtet haben, ist es nun an der Zeit, den iterativen Entwicklungsprozess und die technologische Grundlage für die Implementierung von GenAI in Softwareprodukte zu beleuchten.

Zu Beginn des Entwicklungsprozesses steht die Analyse der zu lösenden Herausforderungen und die Definition von Erfolgskriterien. Dies umfasst die Identifikation der spezifischen Probleme, die durch GenAI gelöst werden sollen, sowie die Festlegung von messbaren Zielen und Anforderungen. Ein klar definiertes Problem und präzise Anforderungen sind entscheidend, um den Entwicklungsprozess zielgerichtet zu gestalten und die gewünschten Ergebnisse zu erzielen. Wichtige Anforderungen sind die Verfügbarkeit und Qualität der Daten, die Modellgenauigkeit, Systemperformance, Benutzerfreundlichkeit sowie die Integration in bestehende Prozesse. Erfolgskriterien können messbare Verbesserungen der Wartungsprozesse, die Zufriedenheit der Stakeholder, reduzierte Betriebskosten und eine hohe Modellperformance umfassen. Hierbei ist es wichtig, alle relevanten Stakeholder einzubeziehen und deren Perspektiven zu berücksichtigen.

Ein zentraler Schritt ist die Strukturierung und Anbindung relevanter Datenquellen. Dazu gehören z. B. technische Dokumentationen, Knowledge Bases und Maschinendaten. Die Daten müssen in einem Format vorliegen, das für die Modellierung und Analyse geeignet ist. Dies kann die Konvertierung von PDFs in strukturierte Daten oder die Integration von Echtzeit-Sensordaten umfassen. Eine sorgfältige Datenaufbereitung ist entscheidend, um die Qualität der GenAI-Modelle zu gewährleisten. Lessons learned zeigen, dass unstrukturierte und inkonsistente Daten zu fehlerhaften Ergebnissen führen können. Daher ist eine gründliche Datenbereinigung und -validierung unerlässlich.

Nach erfolgreicher Implementierung muss Skalierbarkeit und Monitoring sichergestellt werden.

Die Auswahl passender bestehender Modelle ist entscheidend für den Erfolg der GenAI-Integration. Modelle wie von OpenAI bieten vorgefertigte Lösungen, die an die spezifischen Anforderungen der Applikation angepasst werden können. Die Integration dieser Modelle in die bestehende Softwarearchitektur erfolgt über APIs oder andere Schnittstellen. Hierbei ist es wichtig, die Leistungsfähigkeit und Skalierbarkeit der Modelle zu berücksichtigen. Erfahrungen aus der Praxis zeigen, dass eine enge Zusammenarbeit zwischen Entwicklern und Domänenexperten die Integration erleichtert und die Qualität der Ergebnisse verbessert. In einigen Fällen kann es jedoch auch sinnvoll sein, auf traditionelle Machine-Learning-Modelle zurückzugreifen, insbesondere wenn es um strukturierte Daten oder spezifische Vorhersageaufgaben geht, bei denen GenAI-Modelle nicht die beste Leistung liefern. Solche Modelle bieten oft eine präzisere Steuerbarkeit und benötigen weniger Rechenressourcen, was in bestimmten Szenarien vorteilhaft sein kann. Dies soll aber hier nicht weiter vertieft werden.

Ein iterativer Prozess der Evaluierung und Optimierung ist notwendig, um die Leistung der GenAI-Modelle kontinuierlich zu verbessern. Dies umfasst Tests, Nutzungsfeedback und die Feinabstimmung der Prompts. Durch regelmäßige Überprüfung und Anpassung kann die Genauigkeit und Effizienz der Modelle gesteigert werden. Lessons learned aus verschiedenen Projekten zeigen, dass eine kontinuierliche Überwachung und Anpassung der Modelle entscheidend ist, um deren Leistungsfähigkeit langfristig zu sichern. Hierbei ist es hilfreich, automatisierte Testverfahren und Monitoring-Tools einzusetzen.

Nach der erfolgreichen Implementierung muss die Skalierbarkeit und das Monitoring der Modellperformance sichergestellt werden. Dies beinhaltet die kontinuierliche Anpassung an neue Anforderungen und die Überwachung der Modellleistung im Betrieb. Skalierbare Cloud-Lösungen wie Azure bieten hier Vorteile in der Flexibilität und Anpassungsfähigkeit.

Erfolgreiche Integration von GenAI: Architekturüberlegung & Tooling

Für die erfolgreiche Integration von GenAI ist eine sorgfältige Datenaufbereitung und die Auswahl passender Modelle entscheidend. Datenquellen müssen strukturiert und bereinigt sein, um qualitativ hochwertige Ergebnisse zu liefern. Passende Modelle wie die von OpenAI oder Azure Cognitive Services werden über APIs integriert, wobei die Leistungsfähigkeit und Skalierbarkeit berücksichtigt werden müssen. Ein iterativer Optimierungsprozess mit Tests und Feedback verbessert kontinuierlich die Modellleistung. Nach der Implementierung sind eine robuste Infrastruktur und regelmäßige Wartungsarbeiten notwendig, um die Modelle aktuell und leistungsfähig zu halten.

Eine modulare Systemarchitektur und die Nutzung von APIs erleichtern die Integration und Skalierung von GenAI-Modellen. Hybride Infrastrukturen kombinieren die Vorteile von Cloud-Services und lokalen Lösungen, um Datensicherheit und Flexibilität zu gewährleisten. Sicherheitskonzepte und Compliance-Maßnahmen sind essenziell, um den Schutz sensibler Daten zu gewährleisten. Die kontinuierliche Überprüfung und Anpassung der Sicherheitsmaßnahmen schützt vor aktuellen Bedrohungen und stellt die Einhaltung regulatorischer Anforderungen sicher.

Optimierung der Maschinenparametrierung mit GenAI: Use Case aus der Praxis

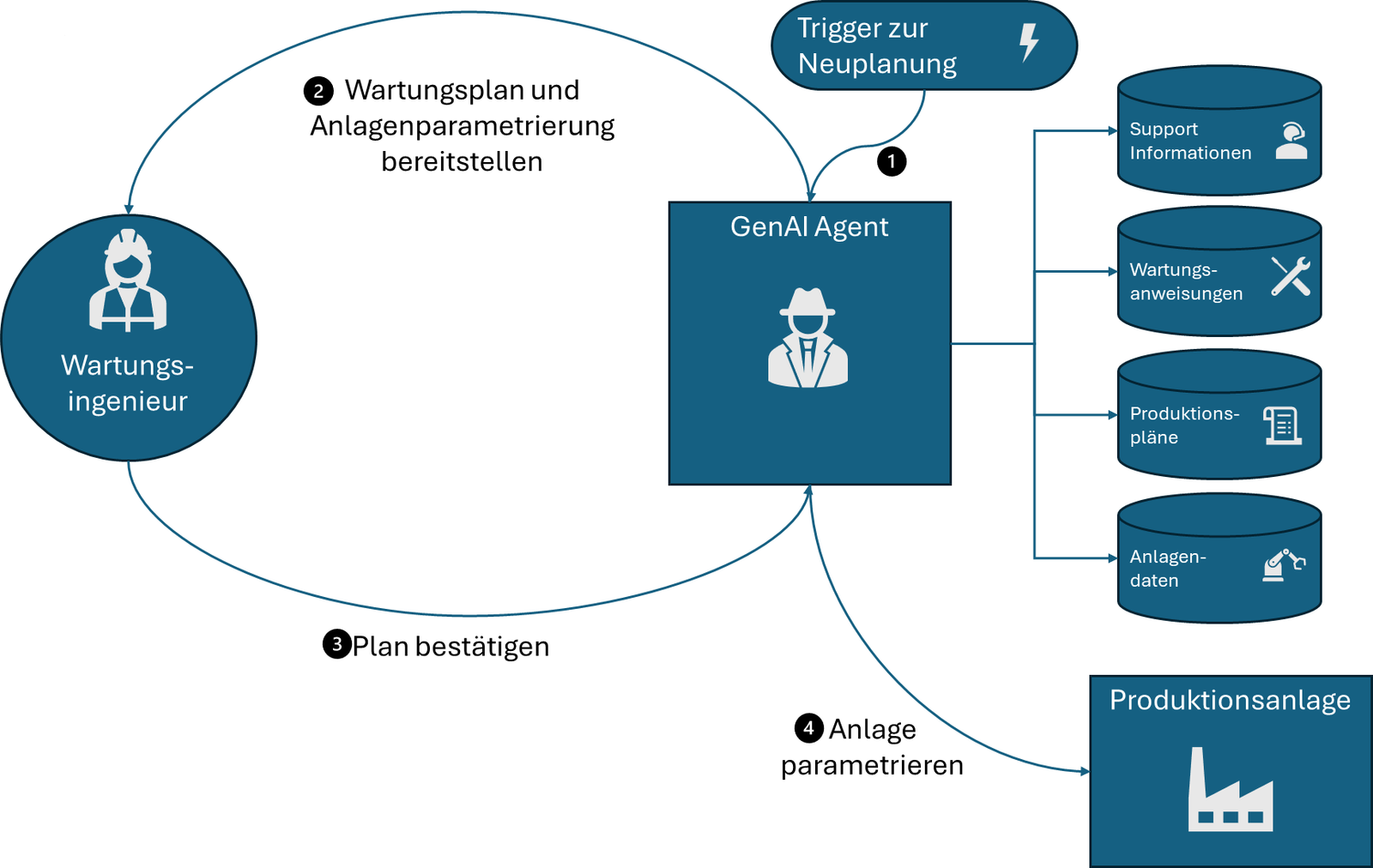

Im Folgenden wollen wir einen Use Case aus der Praxis vorstellen, der die Optimierung der Maschinenkonfiguration mit GenAI beschreibt. Dieser Anwendungsfall zeigt, wie GenAI in der Praxis eingesetzt werden kann und welche technischen Überlegungen dabei eine Rolle spielen.

Ein Maschinenhersteller möchte GenAI nutzen, um die Konfiguration und Wartung seiner Maschinen zu verbessern. Das System soll technische Dokumentationen, eine Knowledge Base und aktuelle Maschinendaten kombinieren, um Wartungsvorschläge und Optimierungen bereitzustellen.

Der Lösungsansatz für die Optimierung der Maschinenkonfiguration beginnt mit der Identifikation und Strukturierung der eingehenden Datenquellen. Dazu gehören technische Handbücher und Wartungsdokumente, die in PDFs oder strukturierten Daten vorliegen, eine Knowledge Base mit Expertenwissen und historischen Servicefällen sowie Echtzeit-Daten der Maschine, wie Sensorwerte, Logs und Betriebsparameter. Eine sorgfältige Datenaufbereitung ist entscheidend, um die Qualität der GenAI-Modelle zu gewährleisten. Lessons learned zeigen, dass unstrukturierte und inkonsistente Daten zu fehlerhaften Ergebnissen führen können. Daher ist eine gründliche Datenbereinigung und -validierung unerlässlich [5].

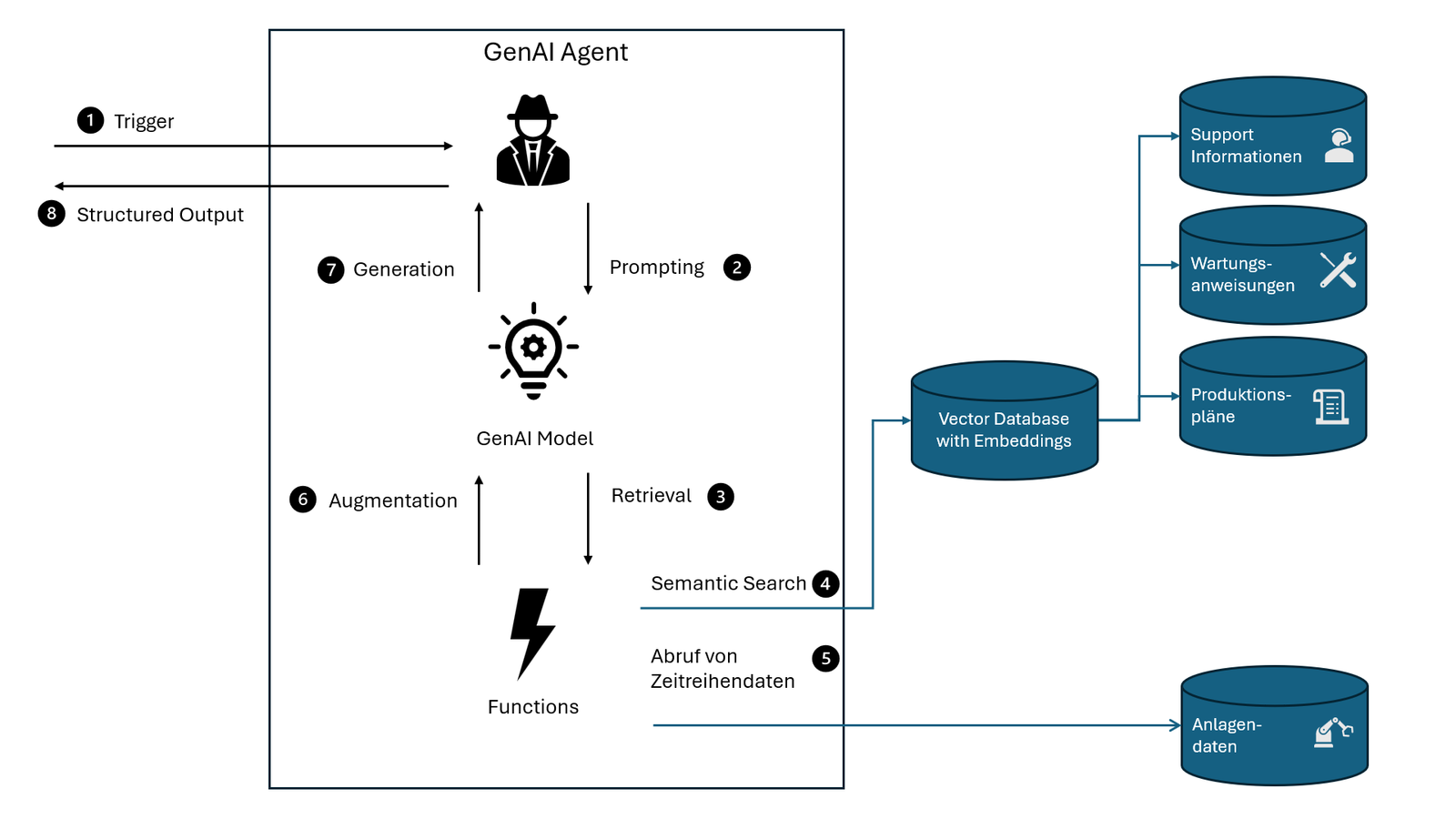

Ein zentraler Bestandteil des Lösungsansatzes ist die Verwendung von Retrieval Augmented Generation (RAG). RAG kombiniert generative KI mit einer gezielten Suche in externen Datenquellen, um präzisere und kontextbezogene Antworten zu liefern. Anstatt sich nur auf ein trainiertes Sprachmodell zu verlassen, sucht RAG in einer Wissensdatenbank nach relevanten Informationen und stellt diese dem Modell als zusätzlichen Kontext bereit. Besonders für unstrukturierte Daten wie PDFs eignet sich dieses Verfahren: Dokumente werden in kleinere Abschnitte zerlegt, in numerische Repräsentationen (Embeddings) umgewandelt und in einer Vektordatenbank gespeichert. Kommt eine Anfrage, werden die relevantesten Abschnitte anhand semantischer Ähnlichkeit abgerufen und dem LLM zur Verfügung gestellt. So können fundierte und aktuelle Antworten generiert werden, die über das ursprüngliche Modellwissen hinausgehen. Embeddings werden heute durch Frameworks wie Semantic Kernel oder LangChain erstellt und abgerufen [6]. Auch Cloud-Dienste wie Azure AI Search machen unstrukturierte Daten durchsuchbar. Hier sind die Kosten nicht zu unterschätzen, um diese unstrukturierten Daten in ein durchsuchbares Format zu bringen. Dabei hilft es, sich im Vorfeld Gedanken zu machen, wie die Daten am besten durchsuchbar abgelegt werden sollten.

Maschinendaten wie Sensorwerte, Logs und Betriebsparameter können in den Retrieval-Prozess integriert werden, um aktuelle, spezifische Informationen zu liefern. So können bei einer Wartungsanfrage etwa Sensordaten zur aktuellen Maschinenauslastung herangezogen werden, um praxistaugliche Empfehlungen zu generieren.

Die Integration des Retrieval-Prozesses erfolgt mit Frameworks wie LangChain oder Semantic Kernel, die eine einheitliche Schnittstelle zwischen Datenquelle und LLM bieten. Diese Tools ermöglichen eine modulare Architektur, die später flexibel angepasst werden kann. Erfahrungen zeigen, dass es hilfreich ist, den Retrieval-Prozess iterativ zu optimieren, indem z. B. verschiedene Ähnlichkeitsmetriken getestet oder Fallback-Strategien implementiert werden.

Ähnlichkeitsmetriken messen, wie ähnlich zwei Texte oder Datenpunkte zueinander sind, indem sie numerische Werte für die semantische Nähe berechnen. Gängige Metriken wie Kosinusähnlichkeit oder euklidische Distanz werden verwendet, um die Relevanz von abgerufenen Informationen zu bestimmen. Fallback-Strategien hingegen kommen zum Einsatz, wenn die primäre Methode keine ausreichenden Ergebnisse liefert; sie erweitern die Anfrage oder generieren alternative Antworten, um sicherzustellen, dass der Nutzer dennoch nützliche Informationen erhält. Beide Techniken sind entscheidend, um die Effizienz und Genauigkeit des Systems in variablen Szenarien zu steigern.

Sobald die Dateninfrastruktur steht, wird das LLM dank Semantic Kernel oder LangChain in die eigene Anwendung integriert. Im Gegensatz zu chatbasierten Integrationen ist hierbei die Verwendung von Structured Output wichtig [7]. Dabei antwortet das Modell in einer formatierten Struktur, wie JSON oder Tabellen, anstatt unstrukturierte Textantworten zu generieren. Dies ermöglicht eine einfache Weiterverarbeitung der Daten und eine klare Kommunikation der Ergebnisse, die direkt in bestehende Systeme integriert oder für den Benutzer visualisiert werden können. Die strukturierten Antworten können direkt in Frameworks wie Semantic Kernel definiert werden, beispielsweise anhand eines JSON-Schemas. Dies gewährleistet, dass die Ausgabe in vordefinierte Felder aufgeteilt wird, wie etwa für Wartungsempfehlungen, Fehlercodes oder präzise Handlungsschritte. Auf diese Weise kann man gezielt die Ergebnisse in der Applikation an den für den Nutzer geeigneten Stellen und im passenden Format anzeigen, ohne sich auf den typischen Einsatzfall eines GenAI-Chatbots zu beschränken.

Regelmäßige Nutzungsfeedbacks und A/B-Tests sind entscheidend.

Die Herausforderung bei der Integration in die eigene Anwendung besteht darin, eine effiziente Pipeline zu schaffen, die das Modell performant und skalierbar nutzt. In dieser Phase ist LangFuse nützlich, um Prompts zu versionieren, das Tracing zu ermöglichen und Performance-Metriken zu sammeln [8]. Lessons learned zeigen, dass eine kontinuierliche Überwachung notwendig ist, um unerwartete Modellantworten zu identifizieren und gezielt nachzusteuern [9]. Hierbei kommen Metriken wie Genauigkeit, Präzision, Recall, F1-Score und Verzögerungszeiten zum Einsatz, die durch Monitoring-Tools wie LangFuse erfasst werden [10]. LangFuse ermöglicht das Versionieren von Prompts, das Sammeln von Performance-Metriken und das Tracen von Modellantworten, um gezielte Anpassungen vorzunehmen und die Modellqualität kontinuierlich zu verbessern. So können Fehler schnell identifiziert und das Modell iterativ optimiert werden.

Der letzte Schritt ist die Evaluierung und Optimierung. Tools wie Ragas helfen dabei, die Qualität des Modells und der Prompts zu messen [11]. Regelmäßige Nutzungsfeedbacks und A/B-Tests sind entscheidend, um die Retrieval-Logik zu verbessern und das Modell an reale Szenarien anzupassen. Hierbei hat sich gezeigt, dass kleine Optimierungen – z. B. präzisere Chunking-Strategien oder dynamische Prompt-Anpassungen – oft große Verbesserungen bringen. Chunking-Strategien und dynamische Prompt-Anpassungen können direkt im Retrieval-Prozess und der Modellinteraktion durchgeführt werden. Beim Chunking werden große Datenmengen in kleinere, semantisch relevante Abschnitte unterteilt, bevor sie in die Vektordatenbank aufgenommen werden. Dynamische Prompt-Anpassungen finden in der Interaktion mit dem Modell statt, indem die Eingabe je nach Anfrage oder Feedback angepasst wird, um präzisere und relevantere Antworten zu erzielen. Beide Prozesse können in Tools wie LangChain oder Semantic Kernel integriert werden, um die Modellleistung zu optimieren.

Das Ergebnis dieser GenAI-Integration ist, dass Wartungsingenieur:innen gezielte Handlungsempfehlungen und Problemlösungen erhalten. Historische Fehleranalysen und Predictive Maintenance tragen zur Reduzierung der Stillstandszeiten und zu effizienteren Serviceeinsätzen bei.

Künstliche Intelligenz auf den diesjährigen IT-Tagen

Spannende Vorträge und Workshops zum Thema Künstliche Intelligenz erwarten Euch auch auf den IT-Tagen, der Jahreskonferenz von Informatik Aktuell. Die IT-Konferenz findet jedes Jahr im Dezember in Frankfurt statt – dieses Jahr vom 08.-11.12.

Fazit

Die Integration von GenAI in moderne Produkte hat das Potenzial, die Art und Weise, wie wir Technologie nutzen und erleben, grundlegend zu verändern. GenAI ermöglicht es, auf Basis bereits existierender Modelle Texte, Bilder, Code und vieles mehr zu generieren, was zu einer erheblichen Effizienzsteigerung und Innovation in verschiedenen Branchen führen kann. Durch die Nutzung dieser Technologien können Unternehmen ihre Produkte und Dienstleistungen personalisieren, die Benutzererfahrung verbessern und neue Geschäftsmöglichkeiten erschließen.

In diesem Artikel haben wir uns auf den praktischen Einsatz bereits existierender GenAI-Modelle in eigenen Anwendungen konzentriert, Hinweise zur Bewertung von Anwendungsszenarien gegeben und technische Optionen zur Integration aufgezeigt. Wir haben gesehen, dass die erfolgreiche Implementierung von GenAI einen iterativen, agilen Entwicklungsprozess erfordert, der durch eine sorgfältige Datenaufbereitung, die Auswahl passender Modelle und eine kontinuierliche Evaluierung und Optimierung gekennzeichnet ist.

Ein zentraler Bestandteil des Lösungsansatzes ist die Verwendung von Retrieval Augmented Generation (RAG), die GenAI mit einer gezielten Suche in externen Datenquellen kombiniert, um präzisere und kontextbezogene Antworten zu liefern. Technische Optionen wie Azure AI Foundry, Microsoft Semantic Kernel und LangChain bieten leistungsstarke Werkzeuge für die Entwicklung und Integration von GenAI-Modellen. LangFuse unterstützt das Prompt-Management, Tracing, Monitoring und die Evaluation von Prompts und Modellen.

Zusammenfassend lässt sich sagen, dass die Integration von GenAI in Softwareprodukte erhebliche Vorteile bietet, aber auch Herausforderungen mit sich bringt. Ein ganzheitlicher Ansatz, der sowohl technische als auch organisatorische und rechtliche Aspekte berücksichtigt, ist notwendig, um die Potenziale von GenAI voll auszuschöpfen und nachhaltige Wettbewerbsvorteile zu erzielen. Die Zukunftsperspektiven für GenAI sind vielversprechend, und wir können erwarten, dass diese Technologie weiterhin bedeutende Fortschritte in der Softwareentwicklung und Produktinnovation ermöglicht.

- HubSpot: Summarize a record (BETA)

M. Corporation: Automate notetaking in Microsoft Teams meetings - M. Corporation: Get email coaching with Copilot in Outlook

- A. S. S. I. Limited: KI-Foto-Editor: Fotos mit KI bearbeiten – schnell und einfach

- GitHub: GitHub Copilot · Your AI pair programmer · GitHub

A. Inc.: Cursor - The AI Code Editor

K. Veigel: Harting, Microsoft und Siemens bringen KI in die Konstruktion - KI im Blindflug: Wenn schlechte Daten KI-Projekte torpedieren

- Introduction to Semantic Kernel

LangChain - How JSON Schema works for Structured Outputs and Tool Integration

- LangFuse

- Optimizing RAG retrieval: Test, tune, succeed

- Evaluation and monitoring metrics for generative AI

- Ragas