Künstliche Intelligenz interpretierbar machen

Automatisierung ist im Allgemeinen eine gute Sache. Sie erledigt einfache, sich wiederholende Aufgaben und erlaubt Unternehmen, freigewordene Ressourcen für neuere, interessantere Probleme einzusetzen. Und da Machine-Learning-Modelle Entscheidungen automatisieren, sind auch sie im Allgemeinen eine gute Sache.

Bei ML-Modellen gibt es jedoch einige Probleme, insbesondere bei den sogenannten Black-Box-Modellen.

Black-Box-Modelle

Ein Black-Box-Modell ist ein Modell, das man durch bloßes Betrachten seiner Parameter nicht mehr interpretieren kann. Ein lineares Regressionsmodell kann man anhand der Steigungsparameter noch interpretieren, aber bei einem neuronalen Netzwerk geht das nicht mehr.

Drei Geschichten sollen die häufigsten Probleme mit Black-Box-Modellen veranschaulichen. Im Laufe dieses Artikels lernen wir drei Methoden kennen, mit denen wir jeweils eines dieser Probleme lösen werden:

- Fairness: Im Oktober 2018 wurde in den Schlagzeilen der Welt über ein KI-basiertes Rekrutierungstool [1] von Amazon berichtet, das Männer bevorzugte. Das Modell wurde auf verzerrten Daten trainiert, die eher auf männliche Kandidaten ausgerichtet waren. Als Konsequenz wurden Regeln erstellt, die Lebensläufe mit dem Wort "women’s" benachteiligten [2].

- Verstehen: Immer mehr wissenschaftliche Disziplinen (z. B. Bioinformatik) verwenden ML-Modelle für die Forschung. In diesen Fällen möchten wir Daten verwenden, um wissenschaftliche Erkenntnisse zu extrahieren. Dann ist selbst ein sehr präzises Modell nutzlos, wenn wir keine Erklärung dafür bekommen, wie die Input-Variablen mit der Zielvariablen zusammenhängen [3].

- Erklärbarkeit und Debugging: Im 71. Erwägungsgrund der DSGVO heißt es: "Die betroffene Person sollte das Recht … auf Erläuterung der … Entscheidung [haben]". Als Folge dieses Gesetzes hat die polnische Regierung im Februar 2019 eine Änderung des Bankengesetzes veranlasst, die besagt, dass eine Bank erklären muss, warum ein Kredit nicht gewährt wurde, falls die Entscheidung per KI – also automatisiert – getroffen wurde.

Ein verwandtes Problem ist das Debugging eines ML-Modells, um beispielsweise herauszufinden, warum einige Daten falsch klassifiziert wurden. Wenn Sie wissen, in welchen Situationen genau Ihr Modell eine schlechte Performance hat, sind Sie besser dafür gerüstet, das Modell zu verbessern oder auszutauschen.

Ein gutes Beispiel dafür ist aus einem Artikel von Ribeiro et al. 2016 [4], das Klassifizierungsproblem "Husky oder Wolf?", bei dem einige Huskys auf Bildern als Wölfe – also falsch – klassifiziert wurden. Wenn Sie sich in Abb. 1 rechts die Pixel ansehen, die die Entscheidung am meisten beeinflusst haben, stellen Sie fest, dass es nur auf den Hintergrund ankommt – das Modell hatte also gelernt, den Schnee im Hintergrund als starken Indikator für "Wolf" zu verwenden:

Mit dieser Erkenntnis wissen Sie nun, dass dieses Modell verbessert werden kann, wenn Sie die Trainingsdaten mit mehr Bildern von Huskys im Schnee anreichern.

Interpretierbares Machine Learning (IML) zur Rettung!

Die Lehre aus diesen drei Geschichten ist, dass wir Black-Box-Modelle nicht nur blind anwenden dürfen, sondern auch fähig sein müssen, unter die Haube dieser Modelle zu schauen und ihr Verhalten auch zu verstehen.

Wir möchten, dass unser Modell fair und erklärbar ist.

Oft interessiert uns also nicht nur die Genauigkeit eines Modells [5]: Wir möchten, dass unser Modell fair und erklärbar ist – dies würde auch die gesellschaftliche Akzeptanz unseres Modells und der KI im Allgemeinen erhöhen. Wir legen außerdem viel Wert auf Sicherheit. Beim autonomen Fahren möchten wir zu 100 Prozent sicher sein, dass die Abstraktion für "Radfahrer", die ein neuronales Netzwerk gelernt hat, korrekt ist. Stellen Sie sich vor, ein Modell müsste zwei Räder "sehen", um ein Fahrrad zu erkennen. Dann würde ein Fahrrad mit Taschen über dem Hinterrad nicht erkannt werden, und im schlimmsten Fall von einem selbstfahrenden Auto überfahren werden.

Das Gebiet des Interpretierbaren Machine Learning (IML) soll diese Probleme lösen. Es ist ein relativ junges Gebiet, und als solches ändert es sich schnell, neue Methoden entstehen mit hoher Geschwindigkeit und die Terminologie ist noch nicht einheitlich. Es kursiert z. B. auch der Betriff Explainable AI (XAI) im Internet.

Christoph Molnars Buch "Interpretable Machine Learning" fasst das Forschungsgebiet gekonnt zusammen und gibt eine übersichtliche Einführung in das Thema [6].

Modelle interpretierbar machen

Wenn Sie das Verhalten Ihres Modells verstehen und erklären möchten, haben Sie zwei Möglichkeiten:

Option 1: Verwenden Sie interpretierbare Modelle

Die erste Möglichkeit besteht darin, einfache Modelle zu verwenden, die bereits interpretierbar sind.

Die Standardlösung hier ist ein lineares Regressionsmodell. Es ist immer eine gute erste Wahl, wenn auch nur als Benchmark. Die Regressionskoeffizienten und ihre p-Werte sind ein gutes Maß für die Größe und Wichtigkeit jedes Merkmals.

Ein weiterer Kandidat, insbesondere für Klassifizierungsprobleme, ist ein Entscheidungsbaum. Bäume können auf intuitive Weise visualisiert werden, und die meisten Menschen können sie auch anwenden, um selbst Vorhersagen zu treffen.

Diese einfachen Modelle haben jedoch Nachteile. Der größte ist sicherlich, dass einfache Modelle zwar interpretierbar sind, aber meist unter einer schlechten Vorhersagegüte leiden. Lineare Modelle sind auf lineare Beziehungen beschränkt, daher versagen sie in der Regel, wenn die reale Welt nichtlineare Effekte enthält (denken Sie beispielsweise an die Beziehung zwischen Ihrem Alter und Ihrer Körpergröße).

Einfache Modelle waren in den 1980er Jahren beliebt, als die Forschung eher über kleine Datensätze verfügte (z. B. in der Medizin). Lineare Modelle und Entscheidungsbäume sind genau aus dem Grund einfach, weil sie eine Reihe sehr restriktiver Annahmen enthalten, die in der realen Welt einfach nicht zutreffen. Es muss also einen besseren Weg geben, um die Interpretierbarkeit zu erreichen.

Option 2: Verwenden Sie Black-Box-Modelle und Post-Hoc-Interpretationsmethoden

Eine bessere Option ist es, stattdessen ein komplexes, aber dafür präziseres Black-Box-Modell zu verwenden. Sie können sich im Anschluss mit dem Verstehen und Erklären Ihres Modells befassen, nachdem das Modell trainiert wurde. Solche Methoden werden Post-Hoc-Methoden genannt, denn Sie wenden sie an, nachdem Ihr Modell trainiert wurde.

Interpretationsmethoden

In diesem Artikel stelle ich drei Methoden für IML vor. Jede Methode löst eines der in den drei Geschichten eingeführten Probleme.

Die Methoden sind alle modellunabhängig. Dies bedeutet, dass sie nicht an einen bestimmten Modelltyp (z. B. Random Forests) gebunden sind. Sie können das Modell bzw. die Interpretationsmethode unabhängig voneinander austauschen.

Die Grundidee aller Interpretationsmethoden besteht darin, dass Sie an Ihren Eingabedaten schrauben, sie also manipulieren, und daraufhin die Änderungen in der vorhergesagten Zielvariable betrachten. Nehmen Sie zum Beispiel die Person, deren Kreditantrag gerade abgelehnt wurde, und verändern Sie ihr Gehalt – erhöhen oder verringern Sie es um 10.000 Dollar – und sehen Sie, was mit der Prognose des Modells passiert.

Verwendete Daten und Modelle

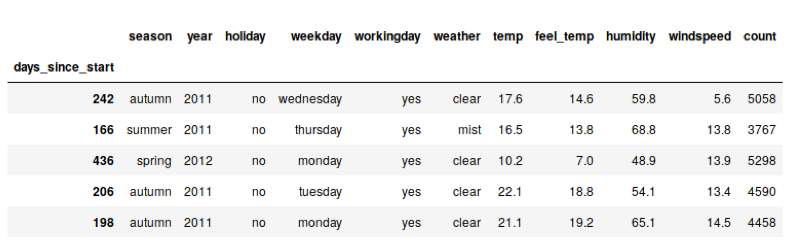

Um die drei Methoden zu veranschaulichen, verwende ich den Bike-Sharing-Datensatz aus dem UCI Machine Learning Repository [7]. Es handelt sich um einen weit verbreiteten Beispieldatensatz, in dem die Aufgabe ist, vorherzusagen, wie viele Fahrräder ein Unternehmen an einem bestimmten Tag verleiht. Die Variablen die für die Vorhersage verwendet werden, sind u. a. Wochentag, Temperatur und Luftfeuchtigkeit an jedem Tag.

Hier sind einige Beispieltage des Datensatzes. Die Originaldaten sind in stündlicher Granularität verfügbar, sie wurden hier schon leicht vorverarbeitet:

Die Zielspalte (count) gibt die Anzahl, der an diesem Tag gemieteten Fahrräder an.

Als Modell trainieren wir einen einfachen Random Forest. Da die Methoden modellunabhängig sind, spielt das genaue Modell hier keine große Rolle – wir könnten genauso gut jeden anderen Algorithmus verwenden.

Wir betrachten nun die folgenden drei Methoden, mit denen wir unser Black-Box-Modell besser verstehen werden!

- Die Permutation Feature Importance (PFI) ist eine globale Methode, mit der die Wichtigkeit der einzelnen Einflussvariablen erklärt wird.

- Partial Dependence Plots (PDPs)sind eine globale Methode, mit der die Auswirkungen der einzelnen Features erläutert werden.

- Shapley-Werte sind eine lokale Methode, mit der die Auswirkungen der einzelnen Features erläutert werden, jedoch für eine einzelne Vorhersage.

Permutation Feature Importance (PFI)

In einem linearen Modell kann die Wichtigkeit eines einzelnen Merkmals durch den standardisierten Regressionskoeffizienten (oder den zugehörigen p-Wert) gemessen werden. Die Permutation Feature Importance (PFI) ist nun eine verallgemeinerte, modellunabhängige Version dieses Werts. Die PFI wurde erstmals in Leo Breimans Aufsatz über Random Forests beschrieben [8], kann aber auch für jedes andere Modell verwendet werden.

Der grundlegende Algorithmus zum Berechnen der PFI für ein bestimmtes Feature (d. h. eine Spalte) lautet wie folgt:

- Prognostiziere die Zielgröße mit den echten Daten.

- Mische die Spalte, für die die PFI berechnet werden soll.

- Prognostiziere das Ergebnis erneut mit diesen gemischten Daten.

- Berechne die Differenz zwischen der Genauigkeit der Vorhersagen mit den originalen und den gemischten Daten.

- Berechne den Durchschnitt dieser Werte.

Wenn die betrachtete Variable ganz unwichtig für die Vorhersage ist, dann hat das Permutieren (also das Mischen) dieser Werte keinen Einfluss auf die Vorhersagegüte. Falls es aber eine sehr wichtige Spalte ist, dann wird durch das Permutieren viel Information zerstört und die Vorhersagegüte wird sehr darunter leiden.

Beachten Sie auch, dass das Modell nicht ein weiteres Mal mit neuen Daten trainiert werden muss. Dieses Vorgehen spart viel Zeit, da das Training meist die aufwändigste Aufgabe ist. Das PFI für ein Feature erfasst automatisch auch Interaktionseffekte, da durch das Permutieren einer Spalte auch alle Interaktionseffekte mit anderen Features zerstört werden, die möglicherweise vorhanden sind.

Schauen wir uns die Feature Importance in unserem Random Forest an, um herauszufinden, welche Features am wichtigsten sind. Python hat ein Paket namens eli5[9], das eine Funktion zur Berechnung der PFIs bietet (s. Abb. 3).

Hier sehen wir, dass das wichtigste Merkmal das Jahr des Datums ist (in den hier verwendeten Daten wurde nur der Jahresteil des Datums aufgezeichnet). Dies macht auch Sinn, da diese Firma zwischen 2011 und 2012 stark gewachsen ist und somit zu späteren Zeitpunkten mehr Fahrradverleihe erwarten konnte.

Das zweitwichtigste Merkmal ist die Temperatur an diesem Tag, und das drittwichtigste Merkmal ist die Luftfeuchtigkeit. Auch dies entspricht dem, was wir erwarten würden: Mehr Fahrräder an wärmeren Tagen, aber weniger Fahrräder, sobald es zu heiß wird (wieder eine nichtlineare Beziehung!). Auch mehr Luftfeuchtigkeit ist wahrscheinlich schlecht für den Verkauf – aber dazu kommen wir im nächsten Abschnitt über Partial Dependence Plots.

Wenn wir uns nochmal an das erste der drei Probleme erinnern, die wir am Anfang dieses Artikels besprochen haben (die Fairness eines ML-Modells), können wir sehen dass die PFI eine mögliche Lösung für dieses Problem ist. Denn wenn wir sehen können, wie wichtig eine Variable für die Vorhersage ist, können wir sicherstellen, dass Merkmale wie das Geschlecht einer Person keinen großen Einfluss auf die Vorhersage haben, und somit ein ungewolltes Benachteiligen verhindern.

Partial Dependence Plots

In einem linearen Modell kann der Effekt eines einzelnen Features anhand des Regressionskoeffizienten des Features gemessen werden. Ein Partial Dependence Plot (PDP) ist eine verallgemeinerte, modellunabhängige Version dieses Wertes.

PDPs wurden erstmals in Friedmans Aufsatz über Gradient Boosting Machines beschrieben [10]. Am intuitivsten ist es, zunächst zu verstehen, wie ein PDP für ein kategoriales Merkmal erstellt wird. Verwenden wir die Variable season (die Jahreszeit) in unserem Fahrradverleih-Datensatz.

- Für jeden Merkmalswert (Frühling, Sommer, Herbst oder Winter).

- Setze die season des gesamten Datensatzes auf diesen Merkmalswert (z. B. Winter).

- Halten Sie alle anderen Funktionen (Temperatur, Luftfeuchtigkeit usw.) gleich.

- Prognostizieren Sie die Anzahl der gemieteten Fahrräder.

- Bilden sie den Durchschnitt aller Vorhersagen.

Abb. 4 zeigt den PDP für die Saison. Wir gehen also davon aus, dass wir im Frühjahr weniger Fahrräder vermieten werden, während alle anderen Jahreszeiten in etwa gleich sind.

Für stetige Variablen wird ein PDP auf ähnliche Weise aufgebaut. Nehmen wir die tägliche Temperatur für dieses Beispiel: Sie generieren ein Gitter mit Feature-Werten, beispielsweise einen Gitterpunkt pro Grad Celsius. Sie fangen mit -10 °C an. Dann setzen Sie die Temperatur der gesamten Daten auf -10 ° C, prognostizieren die Anzahl der gemieteten Fahrräder und zeichnen diesen Punkt auf. Am Ende verbinden Sie alle Punkte durch eine Linie.

Schauen wir uns die PDPs für die tägliche Temperatur und die Luftfeuchtigkeit an (Abb. 5).

Wir sehen hier, dass wir bei wärmerem Wetter mehr Fahrräder verleihen können, aber wenn es zu heiß wird, leihen die Leute wieder weniger Fahrräder aus. Die ideale Temperatur scheint im Bereich zwischen 12 und 21 Grad zu liegen.

Bei höheren Werten (über 60% Luftfeuchtigkeit) wirkt sich die Luftfeuchtigkeit negativ aus, bei niedrigeren Werten spielt der tatsächliche Wert jedoch keine Rolle.

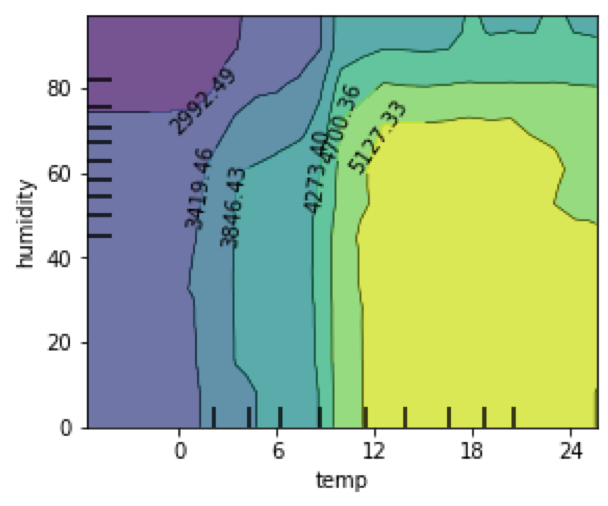

Sie können auch einen zweidimensionalen PDP für zwei Features gleichzeitig zeichnen. Dies visualisiert dann auch die Interaktion zwischen zwei Variablen. Sehen wir uns den PDP für Temperatur und Luftfeuchtigkeit an (s. Abb. 6). Wir sehen, dass das "ideale" Wetter zwischen 12 und 21 Grad und weniger als 70% Luftfeuchtigkeit liegt.

Wenn Sie sich nun wieder an die zweite Geschichte in unserer Einleitung erinnern, werden Sie feststellen, dass PDPs eine mögliche Lösung für dieses Problem sind, dass Forschungsinstitute nicht nur ein präzises Modell haben möchten, sondern auch verstehen wollen, wie die Einflussvariablen die Zielgröße verändern. Sie visualisieren die Auswirkungen der einzelnen Features auf die Vorhersage des Modells und bekommen dadurch Informationen über das Verhalten des Modells und im Idealfall auch Erkenntnisse über die Situation in der realen Welt.

Shapley-Werte / SHAP

Shapley-Werte – und insbesondere die neue abgeleitete Methode SHAP[11] – sind vielversprechende Methoden. Sie können Shapley-Werte verwenden, um die Bedeutung einzelner Features für eine einzelne Vorhersage zu beschreiben. Durch Aggregation über Dateninstanzen können Sie auch andere Kennzahlen ableiten, z. B. eine Art Feature Importance. SHAP und die daraus abgeleiteten Kennzahlen könnten sehr wohl die zukünftige Universalmethode des interpretierbaren Machine Learnings werden.

Intuitiv lautet die Frage, die durch Shapley-Werte beantwortet wird, wie viel jedes Feature zu einer bestimmten Vorhersage beiträgt. Als Beispiel betrachten wir die Interpretation eines prognostizierten Wohnungsverkaufspreises von 320.000 €. Die Wohnung umfasst eine Größe von 64 qm, sie liegt im 5. Stock, es sind keine Haustiere erlaubt, und sie verfügt über einen Balkon. Wie stark hat nun jedes Merkmal die Vorhersage beeinflusst? Nehmen wir an, die durchschnittliche Vorhersage für alle Wohnungen lag bei 300.000 €. Dann könnte eine mögliche Interpretation auf Shapley-Basis so lauten: Die überdurchschnittliche Größe von 64qm hat zusätzlich 15.000 € zum prognostizierten Preis beigetragen, der Balkon 7.000 € und die Keine-Haustiere-Regel -2.000 €.

Für lineare Modelle kann der Beitrag jedes Features leicht bestimmt werden: βj · xj ist der additive Teil der Vorhersage, der durch die j-te Einflussgröße erklärt wird. Shapley-Werte können nun als Verallgemeinerung dieses Beitrags angesehen werden.

Shapley-Werte haben ein schönes theoretisches Fundament in der Spieltheorie. Ihre Berechnung ist etwas komplex und ich werde hier nicht darauf eingehen. Wenn Sie an den technischen Details interessiert sind, kann ich Sie auf den Originalartikel [11] oder das SHAP-Kapitel in Christoph Molnars Buch [6] verweisen.

Visualisierung von Shapley-Werten

Im Python-Paket shap ist eine sehr elegante Visualisierung von Shapley-Werten verfügbar: Sie zeichnen sie als Kräfte auf, die die Vorhersage vom Basiswert (d. h. der durchschnittlichen Vorhersage über den gesamten Datensatz) wegschieben. Da Shapley-Werte additive Maße sind, können Sie positive und negative Werte gegeneinander abwägen, um zu sehen, welche sich aufheben und welche die Vorhersage am weitesten vom Basiswert entfernen.

Stellen Sie sich vor, Sie arbeiten beim Fahrradverleih und Ihr Chef stürmt herein, um zu fragen, warum wir gestern nur so wenige Fahrräder vermietet haben: "Es waren perfekte 15,4 °C, warum hat niemand unsere Fahrräder ausgeliehen?"

Sie würden ihm Abb. 7 zeigen und können nun argumentieren: "Ja, die Temperatur war gut, aber dieser Effekt wurde durch die hohe Luftfeuchtigkeit von 91,7 Prozent wieder ausgeglichen. Und dann hat das Wetter ("light rain") die Zahlen noch weiter nach unten gedrückt".

In diesem Beispiel wirkte sich auch das Kalenderjahr 2011 stark negativ aus (da der Fahrradservice von 2011 bis 2012 stark gewachsen ist, wurden 2011 viel weniger Fahrräder vermietet als 2012).

Shapley-basierte Feature Importance

Eine sehr schöne Eigenschaft von Shapley-Werten ist, dass Sie sie aggregieren und dann auf verschiedene Arten darstellen können. Zusätzlich zu den oben dargestellten lokalen Erklärungen können Sie sie also zu einer globalen Erklärung für Ihr gesamtes Modell aggregieren.

Ein Maß für die Wichtigkeit von Merkmalen kann leicht berechnet werden: Wir mitteln die absoluten Shapley-Werte für jedes Merkmal. Die resultierenden Diagramme ähneln dann stark der zuvor betrachteten Werten der Permutation Feature Importance und können als Alternative dazu verwendet werden (s. Abb. 8).

SHAP-basierter Dependence Plot

Der SHAP-basierte Dependence Plot ist eine einfache Visualisierung von Shapley-Werten und gibt Ihnen einen schnellen globalen Überblick über die Auswirkungen eines Features. Sie sind sehr leicht zu zeichnen:

- Wählen Sie eine Variable aus.

- Zeichnen Sie für jede Beobachtung einen Punkt mit dem Feature-Wert auf der x-Achse und dem entsprechenden Shapley-Wert auf der y-Achse.

Diese Diagramme sind eine Alternative zu den zuvor erläuterten Partial Dependence Plots. Während PDPs durchschnittliche Effekte zeigen, zeigt die SHAP-Abhängigkeit auch die Varianz auf der y-Achse. Insbesondere bei Interaktionen schwankt der SHAP-Abhängigkeitsplot in der y-Achse stärker und verschafft so einen detaillierteren Eindruck.

Shapley-Werte: Fazit

Erinnern wir uns nun an die dritte Geschichte in der Einleitung: Eine Person beantragte einen Kredit und wurde abgelehnt. Wenn diese Person nun eine DSGVO-konforme Erklärung verlangt, warum sie abgelehnt wurde, können Sie jetzt die Shapley-Werte für diese Vorhersage berechnen und ihr zeigen. Vielleicht zeigen sie, dass ihr Einkommen in Ordnung war, aber aufgrund eines vor 15 Jahren ausgefallenen Kredits wurde dann die Kreditwürdigkeit stark beeinträchtigt.

Welche Methode soll ich verwenden?

Die Antwort darauf, welche Interpretationsmethode man verwenden möchte, lautet wie immer: "Es kommt darauf an": Möchten Sie das globale Verhalten Ihres gesamten Modells verstehen, oder die Faktoren, die eine einzelne Vorhersage beeinflusst haben? Möchten Sie nur die Wichtigkeit jedes Features oder auch die Höhe seines Beitrags zur Prognose verstehen? Gibt es Einschränkungen durch die Rechtsabteilung? Müssen z. B. alle Features erläutert werden? Ist das Hauptziel die Vermeidung der Benachteiligung von Minderheiten?

Die Zukunft des interpretierbaren Machine Learnings

Unter der Voraussetzung, dass

- Machine Learning das Treffen von Entscheidungen automatisiert und

- wir gerne alles Mögliche automatisieren, um uns auf neue, anspruchsvollere Probleme konzentrieren zu können,

gehe ich davon aus, dass Machine-Learning-Modelle in der Zukunft viel häufiger im Alltag anzutreffen sein werden.

Interpretierbares Machine Learning wird aus mehreren Gründen eine entscheidende Rolle bei dieser Entwicklung spielen:

- Menschen, die der KI noch skeptisch gegenüber stehen, verlangen viel mehr Transparenz und Erklärbarkeit des Verhaltens eines Modells, um KI in ihrem Unternehmen auszuprobieren.

- Wir können einem Computer nie exakt beschreiben, was er für uns erledigen soll. Er wird einfach naiv das machen, was wir ihm sagen. Wenn z. B. eine Regierung neue Gesetze einführt, kommt es auch dazu, dass die Betroffenen eine Lücke finden und ausnutzen, die vom Gesetzgeber nicht beabsichtigt war. Ähnliche Dinge können mit Machine-Learning-Modellen passieren. Interpretierbarkeitsmethoden helfen uns aber, diese Situationen zu entdecken und zu lösen.

- Ein eingesetztes Black-Box-Modell kann angreifbar sein, z. B. durch adversarial examples [12]: Wenn ein Angreifer weiß, wie man ein Modell täuscht, kann er die Entscheidung nach seinen Wünschen beeinflussen, z. B. ein Stoppschild so verändern, dass ein selbstfahrendes Auto es nicht mehr erkennt. Wer sich gegen diese Angriffe verteidigen will, muss hierfür Interpretierbarkeitsmethoden in Betracht ziehen.

Wie beim Machine Learning selbst wird auch das IML höchstwahrscheinlich in Zukunft automatisiert werden. Wie eine Testsuite, die nach jedem Commit in einem Code-Repository automatisch ausgeführt wird, wird nach jedem neuen Trainieren eines Modells ein automatischer Bericht über Dinge wie die Permutation Feature Importance, Shapley Values etc. erstellt, damit der ML-Engineer sicherstellen kann, dass das Modell noch das tut was es soll.

Aber ich sehe keinen Grund zur Beunruhigung: Wir Data Scientists werden so schnell nicht aussterben. Ähnliches ist bei der Webentwicklung geschehen: Heute kann zwar fast jeder eine Website erstellen, ohne HTML, CSS oder JavaScript zu beherrschen, und dennoch benötigen wir Frontend-Entwickler. Und analog dazu kann bald fast jeder ein Machine-Learning-Modell trainieren, aber wir werden immer noch Experten für Machine Learning brauchen.

- The Guardian: Amazon ditched AI recruiting tool that favored men for technical jobs

- Appsilon: Please, explain. Interpretability of black-box machine learning models

- Arxiv: Explainable Machine Learning for Scientific Insights and Discoveries

- Arxiv: Why Should I Trust You? Explaining the Predictions of Any Classifier

- Cornell University: Towards A Rigorous Science of Interpretable Machine Learning

- Christoph Molnar: Interpretable Machine Learning

- UC Irvine Machine Learning Repository

- Berkeley University: Random Forests

- pypi.org: eli5 0.10.1 pypi.org/project/eli5/

- Stanford University: Greedy Function Approximation: A Gradient Boosting Machine

- NIPS: A Unified Approach to Interpreting Model Predictions

- Cornell University: Wild Patterns: Ten Years After the Rise of Adversarial Machine Learning

Justus

am 27.07.2021